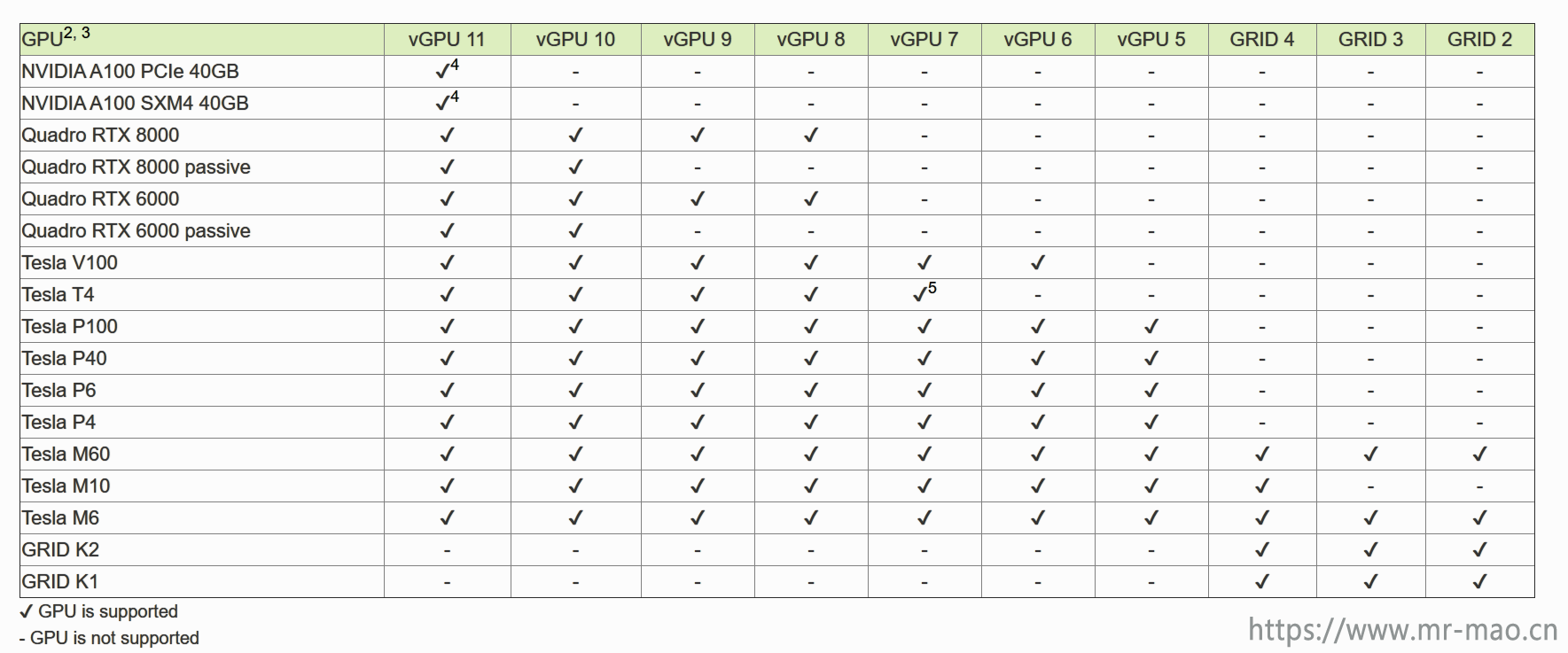

NVIDIA虚拟GPU软件支持的GPU列表

详细信息点击这里

详细信息点击这里

简介:

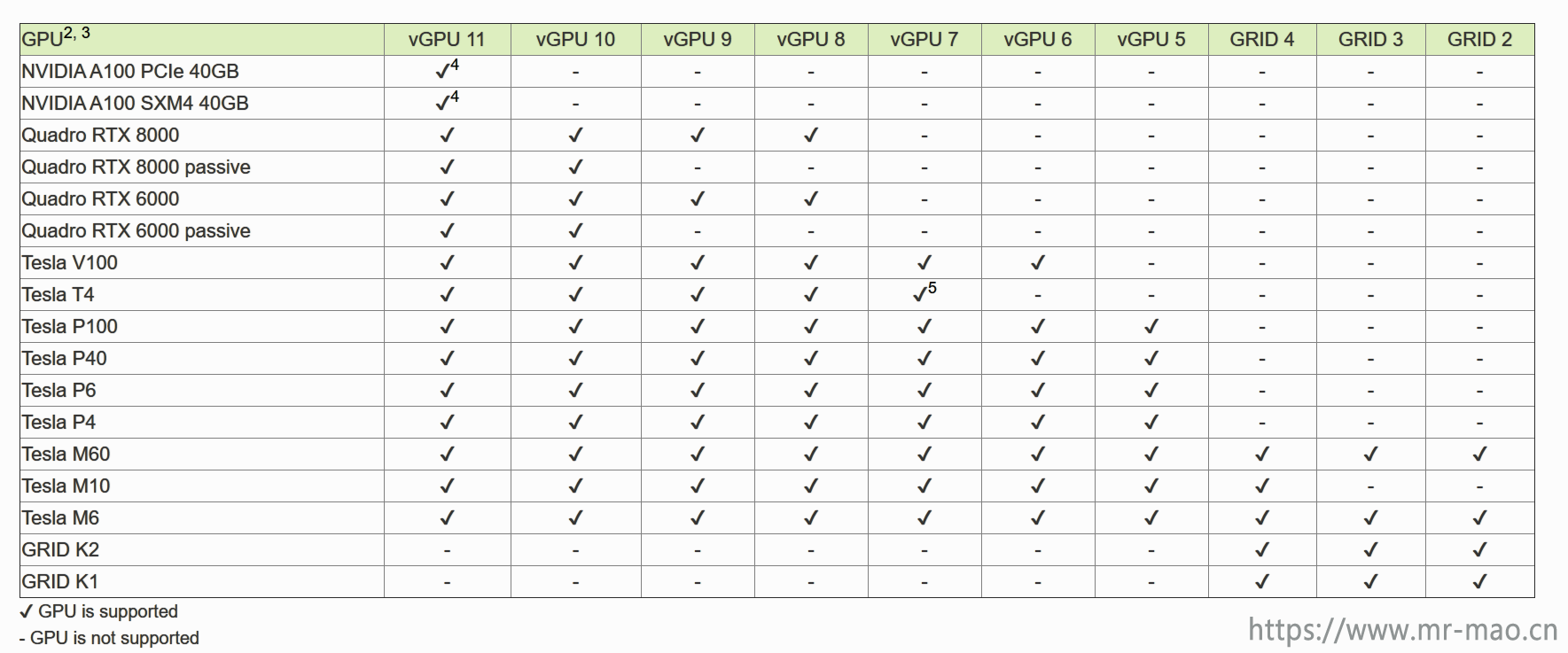

ONTAP Select是一款基于行业领先的数据管理软件构建的软件定义存储(SDS)的解决方案。基于ONTAP存储软件构建,通过高度可用的无共享横向扩展架构高效提供企业级存储服务。为了实现NFS、SMB/CIFS和 iSCSI连接存储,既可以部署只有一两个节点的解决方案,也可以扩展到原始容量最高达400TB的四个节点。可以利用本机重复数据删除和数据压缩功能,通过提高有效容量降低存储成本。横向扩展架构不仅可以帮助您实现高可用性,还可以无中断地移动数据以平衡负载或进行硬件维修。

ONTAP Select具有强大的集成数据保护功能,其中包括NetApp Snapshot® 和 SnapMirror软件。您可以快速高效地将有价值的数据复制到其他ONTAP存储上,无论这些存储是位于内部、远程站点还是云中。如果您必须快速恢复数据, NetApp ONTAP SnapRestore® 软件可以使用本地Snapshot 副本在数秒内恢复全部文件系统或数据卷,无论容量大小或文件数目如何。

ONTAP Select 提供两种许可证(标准版许可证和高级版许可证),在没有许可证的情况下,也可以使用90天的评估版本。

包含90天的评估许可证

允许在每个节点上使用最多2tb的用户存储

无需从NetApp获取序列号和容量许可证

1,硬件环境

ontap select 对硬件环境有要求

a,必需万兆交换机。

b,物理主机内存大于32GB。

c,物理主机除esxi系统盘之外,必须有大于2TB的独立存储。

2,网络准备

建立三个端口组,根据个人喜好自定义端口组,控制器互联端口必须要在万兆交换机上

a,VM Network #集群系统管理端口

b,inter #控制器互联端口

c,data #数据同步端口

3,软件环境,ONTAP 的cifs功能基于域控。

a,必须准备域控制器

b,必须准备NTP服务器

4,下载镜像

https://pan.baidu.com/s/1xAGvtBcSDf68QkAoMhSesA

提取码:

5,部署说明

a,一台物理服务器可以部署一个存储节点

b,两台可以部署2个节点的 HA Pair,或者一套单节点的Mirror 镜像集群

c,我有四台服务器,后面的章节都以双节点集群模式演示

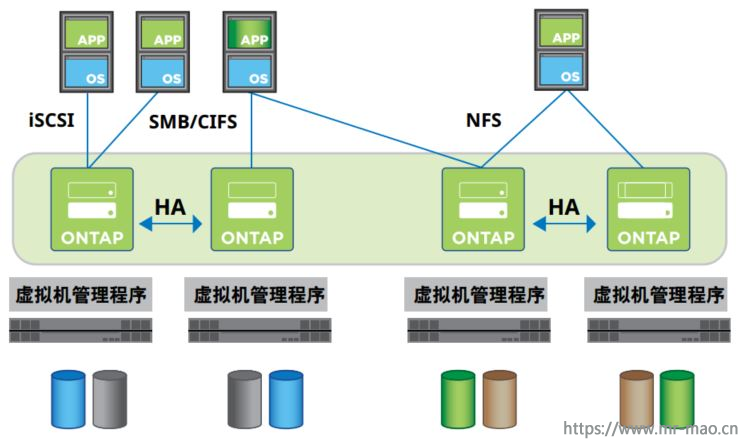

1,选中一台主机,选择部署OVF模板,选择本地文件,选中下载好的ova镜像

2,点击下一步,填写虚拟机名称

3,点击下一步,目标网络选择建立好的管理网络

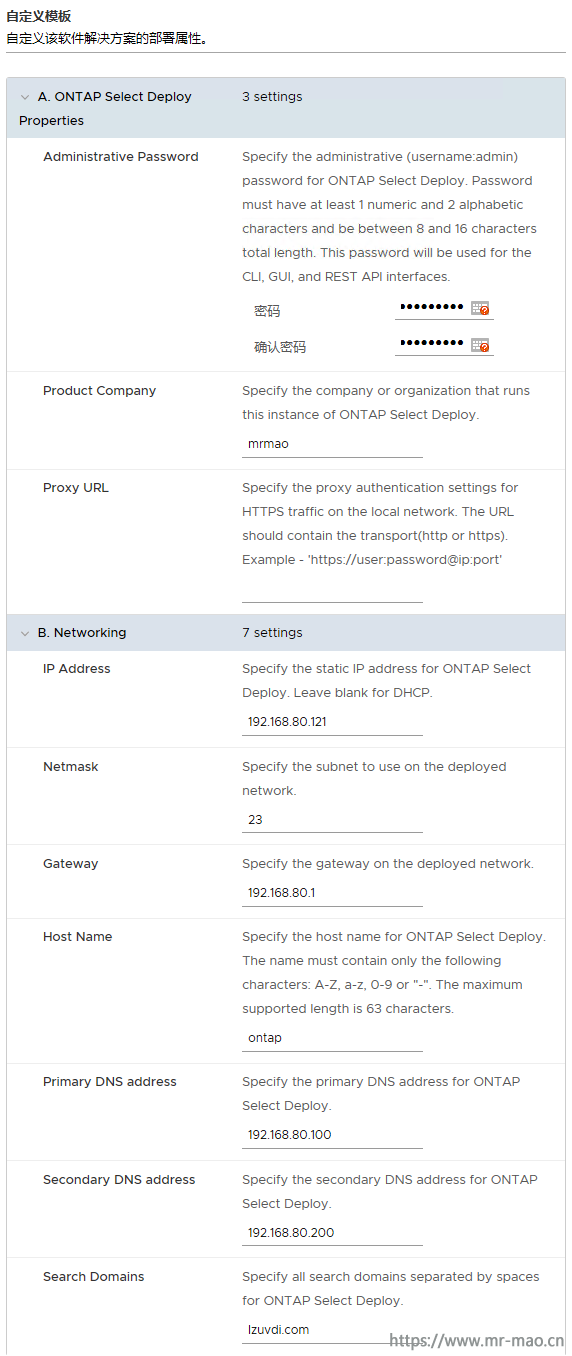

4,点击下一步,根据自己的规划,填写密码,ip信息,填的信息要记住,后面登录要用到

5,点击下一步,然后点击完成,等待导入ova镜像,待操作界面提示导入成功,然后打开虚拟机电源,虚拟机正常启动以后

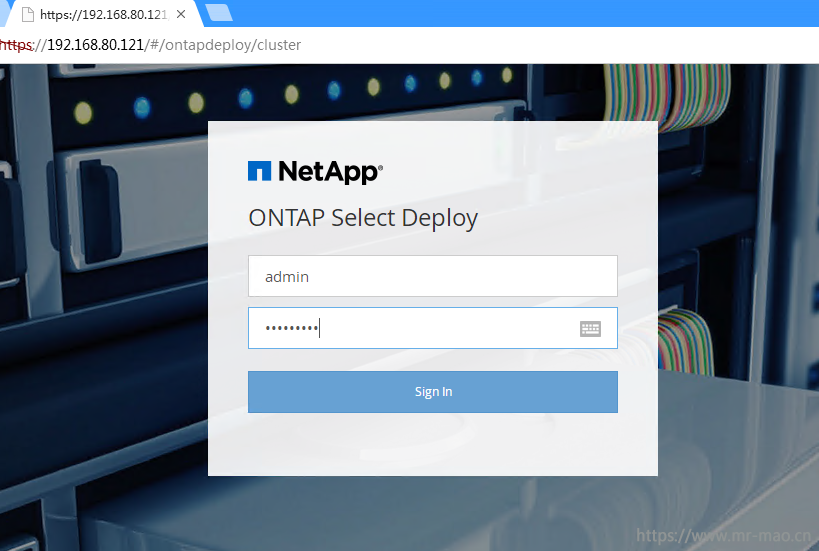

浏览器输入 https://第4步填写的ip 登录

用户名:admin

密码:第4步填写的密码

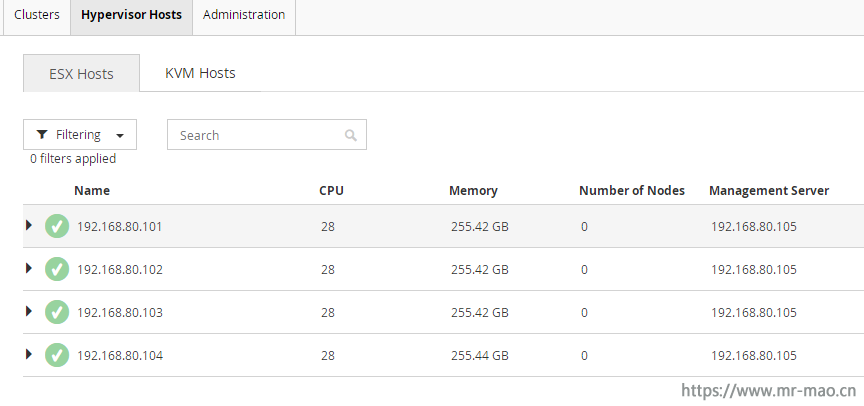

1,添加主机

点击操作界面的Hypervisor Hosts 添加当前环境的esxi主机,如图所示,

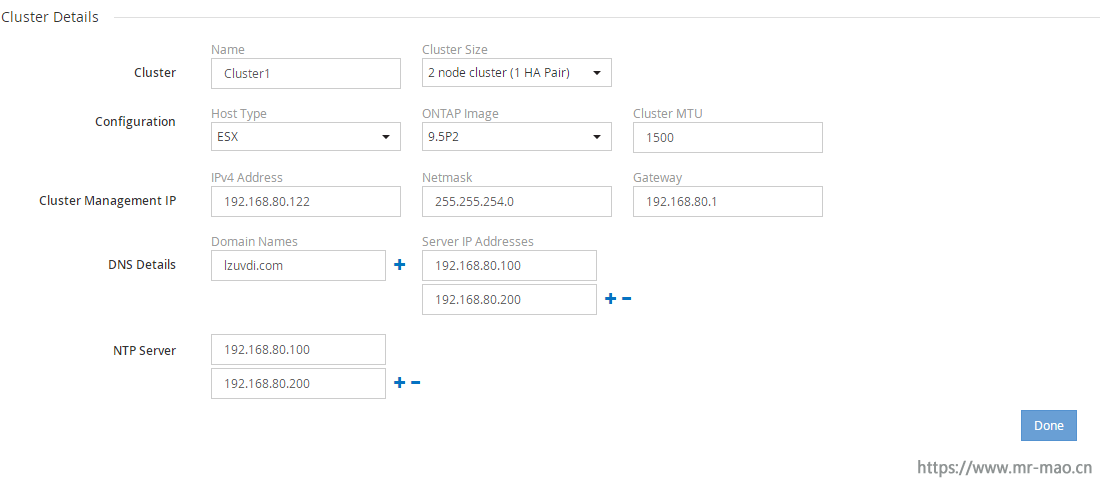

2,创建集群

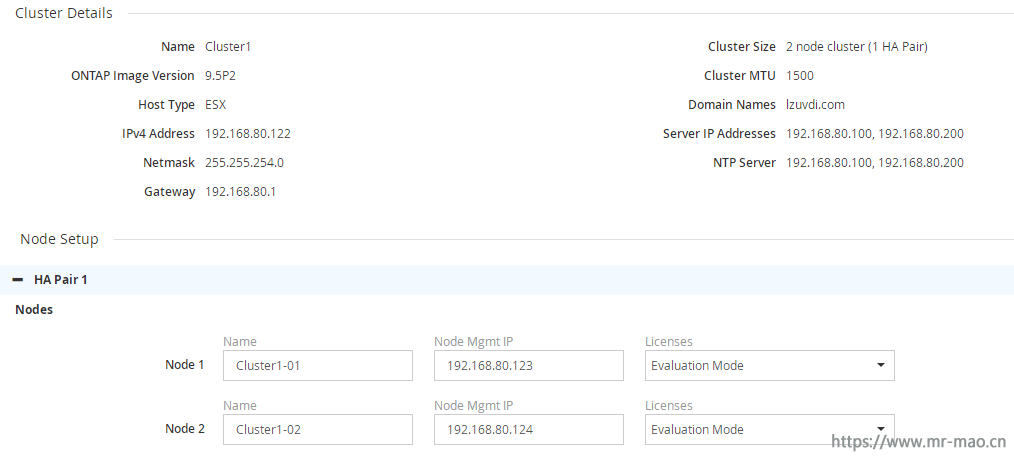

点击操作界面的Clusters,点击 Next,填写集群信息,Cluster Size 根据自己硬件环境选择。

这里有一点要注意,默认的Cluster MTU 是9000,如果你的交换机支持更改MTU,那么就要在交换机全局状态下更改MTU为9000,如果你不懂什么是MTU,那么这里改为1500,点击下一步的时候,会提示,7000-9000的MTU比较适用于select,当前是1500,是否继续,选择yes即可

3,选择许可

点击Done,在HA Pair 界面,license 选择Evaluaton Mode,

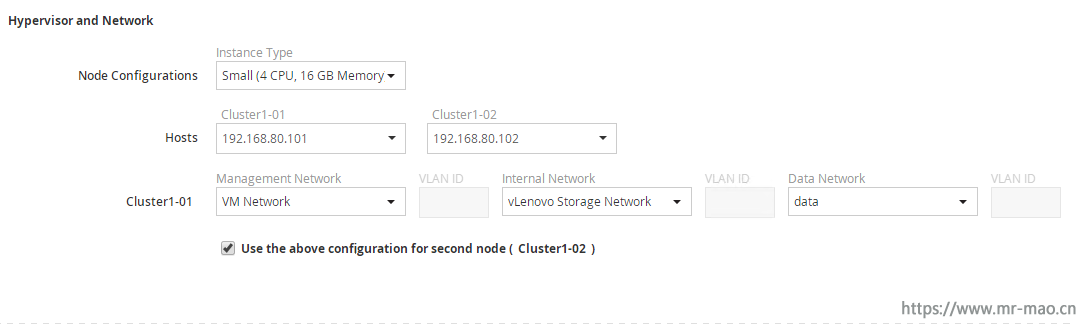

4,配置网络

点击Next,分别为Management Network、Internal Network、Data Netwok,选择建立的端口组

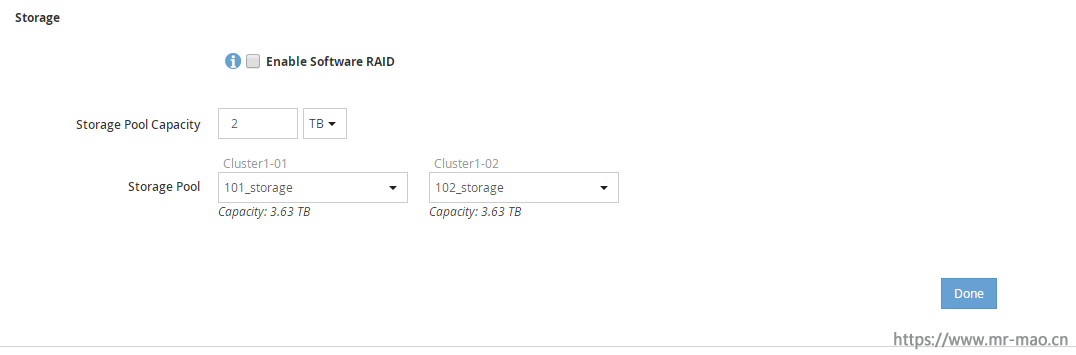

5,配置存储

在Storage 界面,填写Storage Pool Capatity 为2TB

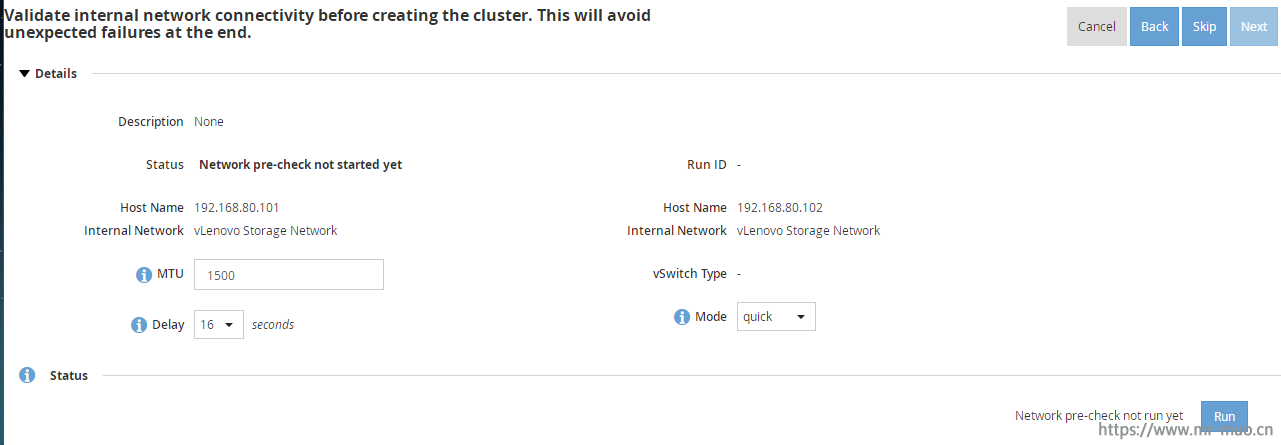

6,测试网络

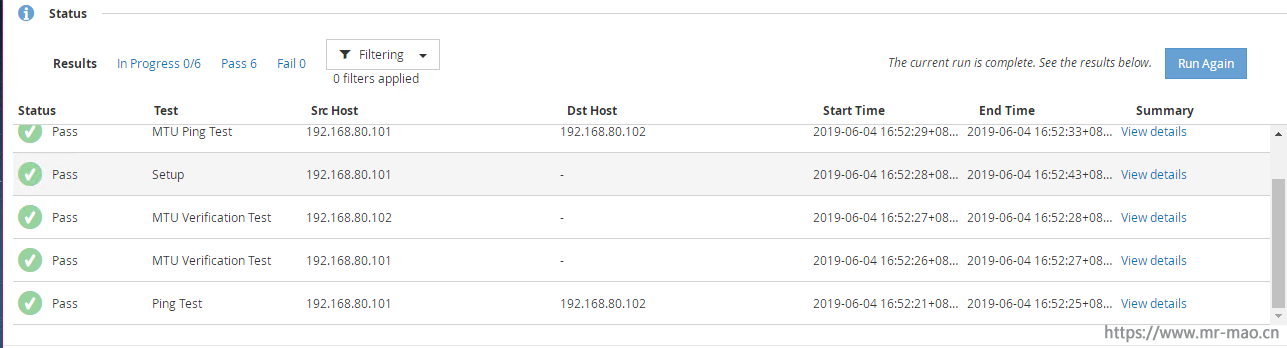

这一步是为了测试当前环境的网络配置是否支持select环境,如果能测试通过,则可以进行下一步,如果不通过,根据提示信息,处理网络故障

点击run

如果都能通过,就可以进行下一步

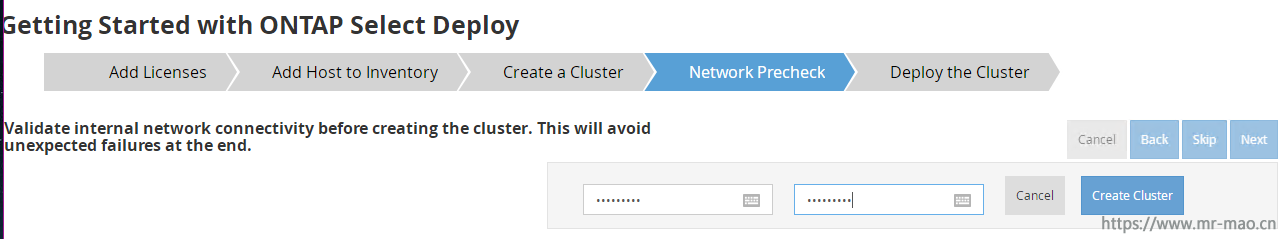

7,建立集群

验证完网络以后,在最上面填写集群密码,然后点击Create Cluster

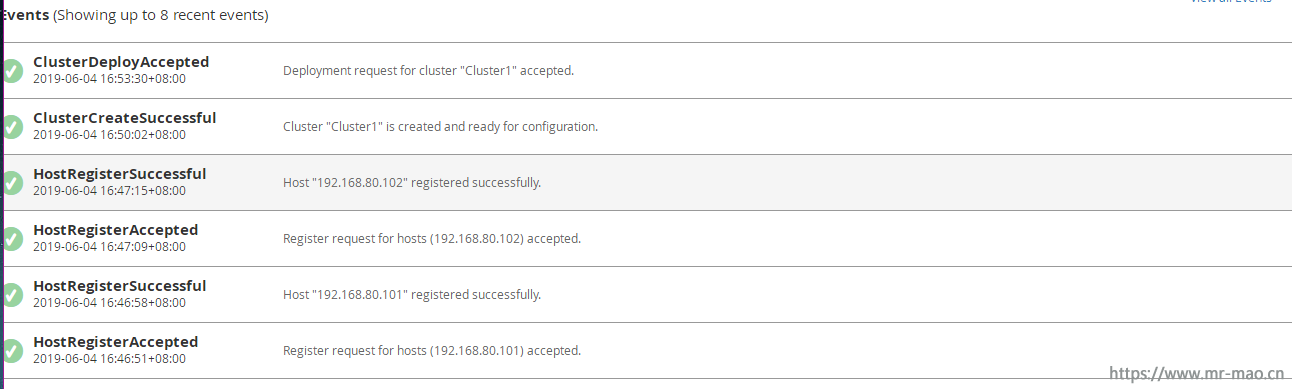

日志信息

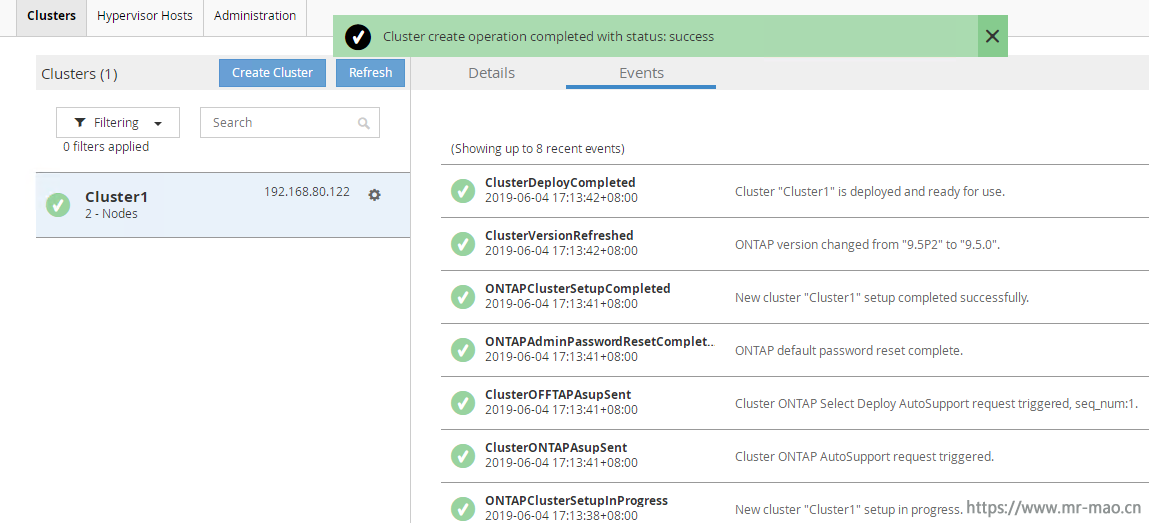

集群创建完毕

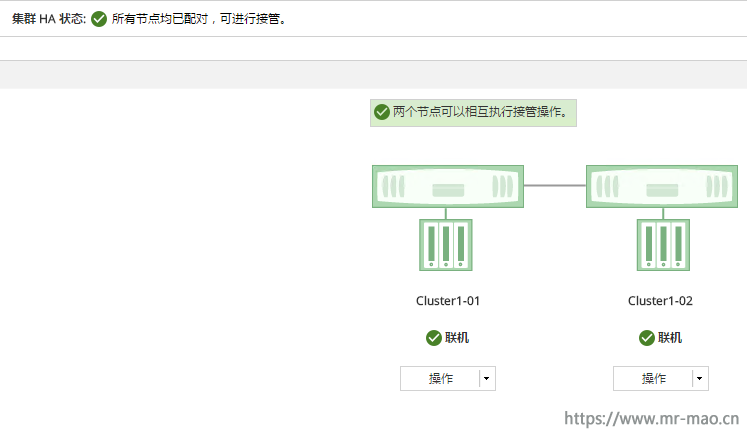

8,查看集群状态

浏览器输入 https://集群管理ip 登录集群系统

在设置界面,查看当前集群HA状态是否正常

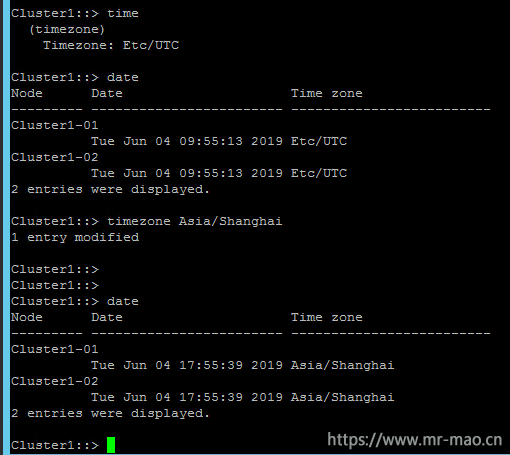

9,配置时间

ssh 登录集群管理ip

输入date,查看时间,发现时区是UTC,

输入 timezone Asia/Shanghai 更改时区

输入date ,查看时间,时间正常

至此,ONTAP select 集群部署完毕,第二章我们讲如何使用。

随着数字化转型的深入,海量数据对存储提出了新的要求。传统存储虽然有技术成熟、性能良好、可用性高等优点,但面对海量数据,其缺点也越来越明显:如扩展性差、成本高等。为了克服上述缺点,满足海量数据的存储需求,市场上出现了分布式存储技术。当前,分布式存储有多种实现技术,如HDFS、Ceph、GFS、GPFS、Swift等。在实际工作中,为了更好地引入分布式存储技术,我们需了解各种分布式存储技术的特点,以及各种技术的适用场景,在此希望请教下同行,城商行应该如何选择这些分布式存储技术,他们各自的特点和场景如何?

在以上几种分布式存储技术中,每一种存储技术都有各自的特点和应用场景。其中HDFS、Ceph和Swift应用比较多,这也和它们的技术发展比较快和应用场景比较多相关。下面分别介绍:

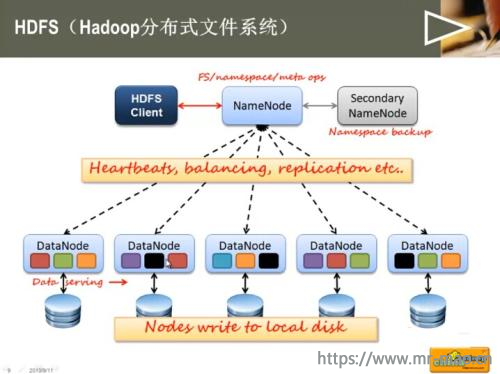

主要用于大数据的存储场景,是Hadoop大数据架构中的存储组件。HDFS在开始设计的时候,就已经明确的它的应用场景,就是为大数据服务。主要的应用场景有:

1、对大文件存储的性能比较高,例如几百兆,几个G的大文件。因为HDFS采用的是以元数据的方式进行文件管理,而元数据的相关目录和块等信息保存在NameNode的内存中, 文件数量的增加会占用大量的NameNode内存。如果存在大量的小文件,会占用大量内存空间,引起整个分布式存储性能下降,所以尽量使用HDFS存储大文件比较合适。

2、适合低写入,多次读取的业务。就大数据分析业务而言,其处理模式就是一次写入、多次读取,然后进行数据分析工作,HDFS的数据传输吞吐量比较高,但是数据读取延时比较差,不适合频繁的数据写入。

3、HDFS采用多副本数据保护机制,使用普通的X86服务器就可以保障数据的可靠性,不推荐在虚拟化环境中使用。

是一个开源的存储项目,是目前应用最广泛的开源分布式存储系统,已得到众多厂商的支持,许多超融合系统的分布式存储都是基于Ceph深度定制。而且Ceph已经成为LINUX系统和OpenStack的“标配”,用于支持各自的存储系统。Ceph可以提供对象存储、块设备存储和文件系统存储服务。同时支持三种不同类型的存储服务的特性,在分布式存储系统中,是很少见的。

Ceph没有采用HDFS的元数据寻址的方案,而且采用CRUSH算法,数据分布均衡,并行度高。而且在支持块存储特性上,数据可以具有强一致性,可以获得传统集中式存储的使用体验。对象存储服务,Ceph支持Swift和S3的API接口。在块存储方面,支持精简配置、快照、克隆。在文件系统存储服务方面,支持Posix接口,支持快照。但是目前Ceph支持文件的性能相当其他分布式存储系统,部署稍显复杂,性能也稍弱,一般都将Ceph应用于块和对象存储。

Ceph是去中心化的分布式解决方案,需要提前做好规划设计,对技术团队的要求能力比较高。特别是在Ceph扩容时,由于其数据分布均衡的特性,会导致整个存储系统性能的下降。

GFS是google分布式文件存储,是为了存储海量搜索数据而设计的专用文件系统。和HDFS 比较类似,而且HDFS系统最早就是根据 GFS的概念进行设计实现的。 GFS同样适合大文件读写,不合适小文件存储。适合处理大量的文件读取,需要高带宽,而且数据访问延时不敏感的搜索类业务。同样不适合多用户同时写入。GFS 是最早的推出分布式存储概念的的存储系统之一,后来的大部分的分布式式文件系统或多或少都参考了 GFS 的设计。HDFS和 GFS 的主要区别是,对GFS 中关于数据的写入进行了一些改进,同一时间只允许一个客户端写入或追加数据。而GFS 是支持并发写入的。这样会减少同时写入带来的数据一致性问题,在写入流程上,架构相对比较简单,容易实现。

GPFS是 IBM 的共享文件系统,它是一个并行的磁盘文件系统,可以保证在资源组内的所有节点可以并行访问整个文件系统。GPFS 允许客户共享文件,而这些文件可能分布在不同节点的不同硬盘上。GPFS提供了许多标准的 UNIX 文件系统接口,允许应用不需修改或者重新编辑就可以在其上运行。

GPFS和其他分布式存储不同的是,GPFS是由网络共享磁盘(NSD)和物理磁盘组成。网络共享磁盘(NSD)是由物理磁盘映射出来的虚拟设备,与磁盘之间是一一对应的关系。所以,使用两台传统的集中式存储设备,通过划分不同的网络共享磁盘,也可以部署GPFS,不一定部署在X86设备上。GPFS文件系统允许在同一个节点内的多个进程使用标准的UNIX文件系统接口并行的访问相同文件进行读写,性能比较高。GPFS支持传统集中式存储的仲裁机制和文件锁,保证数据安全和数据的正确性,这是其他分布式存储系统无法比拟的。GPFS主要用于IBM 小型机和UNIX系统的文件共享和数据容灾等场景。

Swift也是一个开源的存储项目,但是主要面向的是对象存储。和Ceph提供的对象存储服务类似。主要用于解决非结构化数据存储问题。它和Ceph的对象存储服务的主要区别是。

1、客户端在访问对象存储系统服务时,Swift要求客户端必须访问Swift网关才能获得数据。而Ceph使用一个运行在每个存储节点上的OSD(对象存储设备)获取数据信息,没有一个单独的入口点,比Swift更灵活一些。

2、在数据一致性方面,Swift的数据是最终一致,在海量数据的处理效率上要高一些,但是主要面向对数据一致性要求不高,但是对数据处理效率要求比较高的对象存储业务。而Ceph是始终跨集群强一致性。主要的应用场景,在在OpenStack中,对象存储服务使用的就是Swift,而不是Ceph。

Hadoop HDFS(大数据分布式文件系统)

Hadoop分布式文件系统(HDFS)是一个分布式文件系统,适用于商用硬件上高数据吞吐量对大数据集的访问的需求。该系统仿效了谷歌文件系统(GFS),数据在相同节点上以复制的方式进行存储以实现将数据合并计算的目的。

该系统的主要设计目标包括:容错,可扩展性,高效性和可靠性。HDFS采用了MapReduce,不迁移数据而是以将处理任务迁移到物理节点(保存数据)的方式降低网络I/O。HDFS是Apache Hadoop的一个子项目并且安装Hadoop。

OpenStack的对象存储Swift

OpenStack Swift提供一个类似Amazon S3的对象存储。其主要特点为:

所有的存储对象都有自身的元数据和一个URL,这些对象在尽可能唯一的区域复制3次,而这些区域可被定义为一组驱动器,一个节点,一个机架等。开发者通过一个RESTful HTTP API与对象存储系统相互作用。对象数据可以放置在集群的任何地方。在不影响性能的情况下,集群通过增加外部节点进行扩展。这是相对全面升级,性价比更高的近线存储扩展。数据无需迁移到一个全新的存储系统。集群可无宕机增加新的节点。故障节点和磁盘可无宕机调换。在标准硬件上运行,例如戴尔,HP和Supermicro。

Ceph

Ceph是一个遵循LGPL协议的存储平台,它可以在单个分布式节点上同时支持对象存储,块存储和文件存储。

Ceph主要设计的初衷是变成一个可避免单节点故障的分布式文件系统,EB级别的扩展能力,而且是一种开源自由软件,许多超融合的分布式文件系统都是基于Ceph开发的,作为开源软件在超融合商业领域的应用,Ceph因为性能等问题被诟病,但不乏许多厂商在Ceph上不断优化和努力。

IBM General Parallel File System(GPFS通用并行文件系统)

这个专有GPFS是一个由IBM开发的高性能集群文件系统。它可以在共享磁盘或非共享分布式并行模式中进行部署。

GPFS-SNC,其中SNC代表Shared Nothing Cluster(非共享集群),它是2012年12月正式发布的GPFS 3.5版本,如今被称为GPFS-FPO(文件配置优化)。这让GPFS可以在一个联网服务器的集群上采用本地连接磁盘,而不需要配置共享磁盘的专用服务器(例如使用SAN),GPFS-FPO可充当HDFS兼容的文件系统。

GPFS时常通过调用计算集群上的MPI-IO(Message Passing Interface)进行访问。功能包括:

分布式元数据处理。包括目录树。没有单独的“目录控制器”或“索引服务器”管理文件系统。

对非常大的目录进行高效索引目录项。很多文件系统被限制在单一目录(通常, 65536或类似的小二进制数)中的少数文件内,而GPFS并没有这样的限制。

分布式锁定。该功能考虑了完整的Posix文件系统语义,包括锁定文件进行独占访问。

Global Federated File System(GFFS全局联合文件系统)

XSEDE文件系统在美国弗吉尼亚大学Genesis II项目的一部分。

GFFS的出现是源于一个对诸如文件系统的资源以一种联合,安全,标准化,可扩展和透明化的方式进行访问和远程操作的需求,而无需数据所有者或应用程序开发者和用户改变他们存储和访问数据的任何方式。

GFFS通过采用一个全局基于路径的命名空间实现,例如/data/bio/file1。

在现有文件系统中的数据,无论它们是否是 Windows文件系统, MacOS文件系统,AFS,Linux或者Lustre文件系统都可以导出或链接到全局命名空间。

例如,一个用户可以将它 “C” 盘上一个本地根目录结构,C:\work\collaboration-with-Bob导出到全局命名空间,/data/bio/project-Phil,那么用户 “C” 盘\work\collaboration-with-bob 内的文件和目录将会受到访问限制,用户可以通过/data/bio/project-Bob路径在 GFFS上访问。

最后谈一下,最常见的GPFS和HDFS有什么区别?

GPFS和Hadoop的HDFS系统对比起来相当有趣,它设计用于在商用硬件上存储类似或更大的数据——换言之就是,不配置 RAID 磁盘的数据中心和一个SAN。

HDFS还将文件分割成块,并将它们存储在不同的文件系统节点内。

HDFS对磁盘可靠性的依赖并不高,它可以在不同的节点内存储块的副本。保存单一副本块的一个节点出现故障是小问题,可以再复制该组其它有效块内的副本。相较而言,虽然GPFS支持故障节点恢复,但它是一个更严重的事件,它可能包括数据(暂时性)丢失的高风险。

GPFS支持完整的Posix文件系统语义。HDFS和GFS(谷歌文件系统)并不支持完整的Posix语义。

GPFS跨文件系统分布它的目录索引和其它元数据。相反, Hadoop将它们保留在主要和次要Namenode中,大型服务器必须在RAM内存储所有的索引信息。

GPFS将文件分割成小块。Hadoop HDFS喜欢64MB甚至更多的块,因为这降低了Namenode的存储需求。小块或很多小的文件会快速填充文件系统的索引,因此限制了文件系统的大小。

说到分布式文件系统,不得不提到许多超融合厂商,一部分是基于Ceph的,还有一部分是完全自主研发的

本文摘自于 talkwithtrend

问:产品如何获得许可?

答:有两种选择

a,每个实例适用于VM(VMware,Hyper-V,Nutanix)和代理(Windows,Linux)适用于VMware和Hyper-V的每个CPU插槽

b,仅计算“源”管理程序主机(受保护虚拟机所在的位置)。用于复制和迁移作业的目标主机(或VM)不需要获得许可。运行未由Veeam处理的虚拟机的主机不需要获得许可,即使它们是同一群集的一部分。问: Standard,Enterprise和Enterprise Plus版本之间的功能差异是什么?

答:您可以在https://www.veeam.com/products-edition-comparison.html 上找到差异问: CPU核心数是否重要? 答:不,无论CPU核心数量多少,价格都是一样的。

问:是否有任何产品组件单独许可?即企业管理器,备份服务器,备份代理服务器,备份存储库,WAN加速器,磁带库。

答:不,他们没有单独许可。您可以部署尽可能多的组件,因为它们对您的环境有意义。问:我可以使用相同的许可证文件在多个站点上安装多个备份服务器吗?

答:客户可以使用单个许可证密钥部署多个备份基础架构而无需设计限制,前提是他们使用Veeam Backup Enterprise

Manager跨这些基础架构进行集中式许可管理。问:我可以在同一环境中混合搭配不同的产品版本。

A:客户可以使用具有不同许可条款的多个许可证密钥,但仅适用于完全独立的备份基础架构(定义为不共享备份,服务器或彼此之间的存储,并且保护不同的源基础结构)。有关更多详细信息,请参阅许可EULA问:在什么特定时刻,源主机套接字会计入许可套接字池? 答:首次备份,复制或复制在给定主机上运行的VM。

问:我已从环境中删除了一些主机,我可以将其套接字重新插入许可证池吗? 答:是的。在主产品UI中打开许可证管理对话框,选择主机,然后单击“

撤消”。

问:我是否需要新的许可证文件才能安装新版本? 答:总的来说:是的(过去有些例外情况不需要)。

问:以前的版本是否有免费升级?

答:使用Veeam,所有升级对于维护客户都是“免费的”。所有永久许可证购买包括1年的维护。如果您在第一年之后没有延长维护时间,则需要首先通过购买维护(包括“空白”期限)向Veeam销售代表解决此问题。例如,基于许可(订阅),只要您拥有有效订阅,您就有资格升级。问:我是维护的现有客户,如何获取最新版本的许可证文件? 答:请使用

https://my.veeam.com中的许可证管理门户获取新的许可证文件或打开许可证支持案例以获取帮助。如果您选择创建故障单,则预计在产品发布后的前几天会出现延迟响应。

问:我是否需要执行全新安装,还是可以升级现有的贝加莱安装? 答:不,我们支持就地升级。

问:我如何升级?

答:升级过程非常简单明了。确保没有活动或还原进程处于活动状态,并在备份服务器上运行安装程序。安装完成后,启动B&R并按照升级向导自动升级所有剩余组件。有关更多详细信息和分步过程,请参阅发行说明文档的升级部分。如果您使用它,请先升级Enterprise

Manager。问:升级会保留我的工作和其他设置吗?

A:是的,您的所有工作和设置都将被保留。这也意味着默认情况下不会启用潜在的新功能,如果需要,必须手动启用。这是为了确保升级后产品行为保持不变。问:我可以将哪些B&R版本升级到最新版本? 答:请参阅发行说明中的“升级Veeam备份和复制”部分。

问:当前版本和以前版本可以安装在同一台服务器上吗?

A:但是,您可以在不同服务器上并行运行不同版本,同时处理相同的VM而不会出现任何问题(只要作业不重叠)。这是我们大多数客户在升级其生产部署之前选择POC测试新版本的方法。问:企业管理器可以从较旧的Veeam Backup&Replication收集数据吗?

答:一般来说,“是”。这取决于版本。请在发行说明中找到该信息(在升级Veeam备份和复制部分中)问:我可以恢复使用以前的产品版本进行的备份吗? 答:是的。当前版本可以从1.0版开始恢复使用任何版本的Veeam

Backup&Replication进行的备份。

问:产品组件和受保护VM的系统要求和支持的配置是什么? 答:请参阅下载区域

https://helpcenter.veeam.com和“资源”选项卡下的产品页面上的“发行说明”文档的“系统要求”部分。有关其他特定于平台的信息,请参阅特定于平台的FAQ主题。问:是否支持在VM中运行Veeam Backup&Replication? 答:是的。

问: Veeam Backup&Replication是否可用作基于Linux的虚拟设备? 答:不能.VeeamBackup&Replication必须安装在Microsoft Windows上。

问:什么是备份作业?

答:备份作业可生成具有生产VM数据的高度压缩和重复数据删除的备份文件,从而可以节省托管备份所需的大量空间。由于需要从备份中提取并复制完整的VM映像到生产存储,因此从备份完全VM还原通常需要很长时间,但也可以立即为有限数量的VM完成(请参阅即时VM恢复)。问:什么是专为我们设计的备份复制作业?

A:备份复制作业可以在现场(通常用于存档目的)和非现场(以满足异地备份存储要求)有效地创建备份副本。维护备份的多个副本(其中一些是非现场的)由行业最佳实践(称为3-2-1备份规则)决定:至少3个生产数据副本(1个生产和2个备份),备份存储在2种不同的媒体类型,其中1种存储在异地。问:什么是SureBackup作业?

A::SureBackup作业通过启动隔离环境中的一个或多个VM来执行实际的恢复验证,并通过检查VM是否已启动,操作系统是否已启动,VM是否响应以及VM应用程序是否正常运行来验证恢复。SureBackup作业也是U-AIR和按需沙箱功能的关键组件。问:什么是复制作业? A:复制作业可在备用主机上生成生产VM的精确副本。这些副本可以在生产VM关闭时立即启动,不依赖于Veeam

Backup和Replication服务器,并且具有完全的I /

O性能。但是,副本需要备用主机,并且由于以未压缩的本机格式存储,因此需要的磁盘空间多于备份。因此,副本通常用于具有低恢复时间目标的第1层VM。问:什么是VM Copy作业? A:VM

Copy作业可在所选存储上生成所选VM的精确副本,并可用于数据中心迁移,创建测试实验室和临时备份等方案。VM

Copy作业支持处理正在运行的VM。但是,与备份作业不同,VM Copy不支持“增量”运行。仅VMware VM支持VM复制作业。问:什么是文件复制作业?

答:文件复制作业在由Veeam管理的任何服务器(Windows或Linux服务器或管理程序主机)之间复制常规文件,并可用于各种管理任务。文件复制作业不支持处理属于正在运行的VM的虚拟磁盘文件。问:什么是备份到磁带作业?

A:备份到磁带将Veeam备份文件复制到磁带,并完全跟踪磁带目录中复制的备份文件的内容。这允许简化的恢复,恢复过程能够自动选择所需的磁带。问:什么是文件到磁带作业?

答:文件到磁带作业将常规文件从Veeam(Windows或Linux服务器或虚拟机监控程序主机)管理的任何服务器复制到磁带。复制的文件在磁带目录中进行跟踪,但Veeam备份文件被视为常规文件。问:什么是快速迁移工作?

A:迁移作业可以将正在运行的VM移动到选定的主机和存储,同时尽可能减少停机时间。根据您的迁移方案和VMware许可级别,迁移作业将自动利用以下其中一项:VMware VMotion,VMware Storage VMotion,使用SmartSwitch的Veeam快速迁移或使用冷开关的Veeam Quick Migration。这使您可以从需要紧急维护的主机快速撤出VM,而不会影响带宽或性能,或执行数据中心内和数据中心迁移。仅VMware VM支持迁移作业。

问:备份时的数据流是什么? 答:磁盘>备份代理>网络>备份存储库>磁盘

问:什么是备份代理服务器?

答:备份代理从生产存储中提取VM数据(配置文件和虚拟磁盘),通过应用重复数据删除和压缩处理数据以减小其大小,并将其发送到备份存储库(在备份的情况下)或其他备份代理服务器(在复制的情况下)。备份代理还用于将VM数据(配置文件和虚拟磁盘)写回生产存储,生产存储用于VM还原,以及创建和更新副本VM以进行复制。问:为什么最好在物理机上安装代理服务器? 答:因为大量数据流(高达每秒几千兆字节)的即时处理(重复数据删除和压缩)需要大量的CPU,内存和I

/ O资源,所以物理代理服务器最适合24/7虚拟环境整合率。否则,您可能会发现影响生产的备份过程。问:我可以在哪个操作系统上安装代理服务器?

答: 64位或更高版本的Microsoft Windows 7 SP1 / Server 2008 SP2。问:我是否必须设置代理服务器才能开始使用产品?

A:不,因为安装程序会自动部署默认代理服务器。但是,我们建议您添加其他内容以实现冗余和负载平衡。有关最佳部署其他代理的位置的建议,请参阅特定于虚拟机管理程序的常见问题解答。问:代理服务器可以自行备份吗? 答:是的,代理服务器可以备份自己和任何其他Veeam备份和复制组件。

问:什么是备份存储库?

答:备份存储库是存储备份的位置。每个备份存储库都有本地代理,可以在备份代理和备份存储库通过LAN或WAN进行通信时实现增量数据的高效本地处理。问:我应该使用“每个VM备份文件”吗? 答:与默认的“每个作业备份文件”相比,每个VM备份文件有许多优点。优点是: 磁带恢复更容易

错误格式化的NTFS卷上没有16TB文件 通过并行处理提高性能 更轻松的作业管理(将更多虚拟机放在一个作业中) SOBR的资源使用情况

如果文件<1TB,则可选Windows Server 2016 Dedupe 从备份中轻松删除VM 每个VM会计

唯一的缺点是每个VM备份链占用更多空间,因为无法进行跨VM重复数据删除。问:您作为备份存储库支持什么? 答:支持以下存储库: 任何直接连接到Microsoft

Windows服务器的存储。存储可以是本地磁盘,直接连接基于磁盘的存储(例如USB硬盘驱动器),也可以是iSCSI / FC SAN

LUN,以防服务器连接到SAN结构。 直接连接或安装在Linux服务器上的任何存储(支持所有主要发行版的x86和x64,必须安装bash

shell,SSH和Perl)。存储可以是本地磁盘,直接连接基于磁盘的存储(例如USB硬盘驱动器),NFS共享或iSCSI / FC SAN

LUN,以防服务器连接到SAN结构。

SMB(CIFS)分享。支持密码验证。数据可以直接从备份代理服务器或通过网关服务器写入SMB共享(在SMB共享位于远程站点时很有用)。

基于磁盘的重复数据删除设备,与Veeam集成。目前有Dell / EMC DataDomain,ExaGrid,HPE

StoreOnce,QuantumDXI(和OEM)。 问:我可以使用虚拟机作为备份存储库吗?

答:是的,但是请务必认为在发生灾难时要仔细恢复计划。虽然实际的VM不需要运行以便您能够恢复(因为您始终可以直接从存储中导入备份),但请记住,如果将备份文件存储在VM中,灾难可能会影响您检索备份文件的能力位于生产存储上的磁盘。特定于虚拟机管理程序的FAQ中提供了其他建议和注意事项。问:您为底层备份存储推荐了什么RAID级别?

A:我们建议使用RAID6(或任何其他类似的双奇偶校验实现)以实现最佳冗余。RAID10提供更高的性能,尤其适用于I/O密集型备份操作,例如合成完整备份。

问: Veeam是否支持将其备份写入磁带? 答:是的,Veeam为LTO-3和更新版本提供原生磁带支持。有关更多信息,请参阅磁带支持FAQ

问:异地复制备份的最佳方法是什么? 答:备份复制作业到异地备份存储库。考虑使用内置WAN加速来实现慢速链接。

问:我应该选择哪种备份模式? A:这取决于您的要求。随着VBR功能的发展,今天我们推荐以下备份模式: 永远向前增量

使用合成或活动的满员向前增量 反向增量 建议不要使用转换进行前向增量。

使用合成或活动完整备份的转发增量具有以下优势:备份链在备份期间不会更改。这允许在创建新备份时运行虚拟实验室或磁带作业。 Forever

Forward增量优于反向增量,因为合并在备份完成后发生。这意味着可以更快地整合VM快照。如果要将完整备份写入磁带,则需要为Forever

Forward增量创建“虚拟合成备份”,而可以将反向增量完全备份直接写入磁带。 反向增量模式不允许将增量备份写入磁带。问:增量永久备份方法有哪些好处?

A:减少对生产环境的压力,提高完整备份性能,减少备份存储空间,因为无需保留多个完整备份(反向增量,永久前向增量和转发)。问:我正在使用重复数据删除存储设备。合成完全备份对我有好处吗?

答:根据您的存储如何实施重复数据删除(内联,后处理或与DDboost或Catalyst集成),您可以通过使用主动(实际)完全备份而不是合成来获得更好的性能。问:我们制定了一项政策,要求我进行真正的完整备份。我是否被迫使用Veeam的合成装满?

A:不,您可以将作业配置为执行活动(实际)完全备份。此外,您可以安排主动完全备份,例如,每月一次(或每季度一次),同时在其余时间进行合成完全备份。Veeam在安排活动完整备份方面提供了极大的灵活性。问:反向增量备份模式究竟如何工作? 答:请参阅https://www.veeam.com/kb1933

问:前向增量模式的工作原理是什么? 答:请参阅https://www.veeam.com/kb1932

问:高级ReFS集成如何提供帮助? 答:一般来说,它是关于没有主动完全备份的备份模式的性能和空间效率。这篇博文 解释了好处。

问:备份副本的数据流是什么? 答:数据流取决于作业中选择的传输模式。 直接模式:磁盘>源备份存储库>网络>目标备份存储库>磁盘

WAN加速:磁盘>源备份存储库>源WAN加速器>网络>目标WAN加速器>目标备份存储库>磁盘问题:备份复制作业是否真正复制备份文件? 答:否。备份复制作业会创建包含要选择处理的VM的新备份文件。

问:从基础架构,备份和添加主备份作业中选择虚拟机有什么区别?

A:没有区别,这只是为了方便。在所有情况下,备份复制作业都将从备份文件中获取VM数据。问:如何从备份复制作业创建备份复制作业?(源存储库 - > BCJ - >目标1存储库 - > BCJ - >目标2存储库)

答:选择“来自基础结构”并在创建BCJ时添加资源时指定源存储库。

问:复制时的数据流是什么? 答:磁盘>源代理>网络>目标代理>磁盘

问:我可以使用相同的源和目标代理进行复制吗?

答:是的,但仅限于本地复制(现场复制)。在这种情况下,贝加莱调度程序将尽可能尝试使用相同的备份代理。

问:什么是SureBackup工作?

A:SureBackup作业通过在隔离环境中从备份或副本启动一个或多个VM来执行实际的恢复验证,并通过检查VM是否已启动,操作系统是否已启动,VM是否响应以及VM应用程序是否正常运行来验证恢复。此外,为了能够检测存储损坏问题(也称为位腐烂),SureBackup作业可以选择通过读取所有虚拟磁盘块并将内容与块中包含的CRC进行比较来验证完整的VM映像。问: SureBackup作业究竟验证了什么?VM可用性,操作系统启动还是应用程序? 答:所有这一切。有4个步骤或级别的恢复验证:

1.检查VM启动是否成功(API调用结果)。例如,如果备份文件中缺少虚拟磁盘,或者磁盘描述符文件已损坏,则VM将无法启动,vCenter将告知SureBackup问题。

2.通过检查VM心跳检查操作系统是否成功启动。如果操作系统无法启动,则guest虚拟机工具将永远不会启动,并且心跳将永远不会出现。

3.通过ping VM来检查网络连接。如果VM永远不会出现在网络上,这也表明存在一些恢复问题。

4.通过针对它们运行测试脚本来检查VM应用程序。如果应用程序没有响应预期结果的测试脚本,则表示恢复问题。问:以上所有测试都是强制性的吗? A:不可以。您可以为每个VM,容器或链接备份作业定义要精确使用的测试。

问: SureBackup作业将验证哪些虚拟机?

答:来自所选应用程序组的所有VM(这些VM在提供所需基础结构服务的作业期间运行)以及来自链接备份作业的所有VM(这些VM只是逐个启动,验证和停止)。问:我可以看到可以在不指定要使用的应用程序组的情况下设置SureBackup作业。怎么会这样?

A:如果您不关心验证应用程序的可恢复性,并且只是想确保VM可以启动,那么您不必担心某些应用程序可能因为缺少依赖项而无法启动,因此您不需要启动应用程序组并首先运行这些依赖项。只需填写链接备份作业的SureBackup作业,并确保禁用应用程序测试脚本以避免收到验证错误报告。问:如果我没有虚拟化我的域控制器,那么如何在虚拟围栏实验室中引入这些实例? 答:您必须至少拥有一个虚拟化域控制器。

问:我收到了一个虚拟机验证失败的报告。我怎样才能快速了解发生了什么?

问:打开相应的SureBackup作业会话,找到有问题的VM,右键单击它并选择重新启动它。单击VM名称下的超链接以打开其控制台(或使用vSphere客户端),并手动解决恢复问题。问:我们的某些应用程序的验证过程是一个无法编写脚本的手动过程。什么是我们最好的选择?

答:为这些应用程序创建专用的应用程序组。使用此应用程序组创建SureBackup作业,选中“保持VM运行”复选框,并按所需的时间段(例如,完全备份后每周一次)安排作业。虚拟机将坐在那里,等待负责手动恢复验证的人员在早上来到,并通过手动连接到VM来执行所需的测试。

问:您执行了哪种重复数据删除?

答:我们执行无代理,块级,内联(即时)重复数据删除。重复数据删除既发生在源(在将数据发送到备份存储之前,这显着提高了增量备份性能),也发生在目标上(为具有多个VM的作业实现额外减少)。问:典型的数据缩减比率是多少?

答:压缩和重复数据删除率可达到原始大小的10倍甚至更多,但这取决于太多因素,例如作业中的VM数量,这些VM的相似性,虚拟磁盘的内容等。年2倍成为“正常”环境的经验法则。问:10x在软件方面很不错,但其他软件和硬件重复数据删除厂商声称重复数据删除率是100倍以上?

答:要求他们提供他们用来计算重复数据删除率的公式。使用Veeam,10x是单个完整备份文件中的纯重复数据删除率(字节数除以字节数)。其他供应商经常夸大比率,以达到营销目的。这通常通过假设每个备份已满来完成。如果您将这种方法应用于Veeam,那么通过最常见的30天保留策略和每日备份,您将获得高达300倍的“营销”重复数据删除率。这是因为Veeam允许您随时在磁盘上保留一个完整备份(无论您的保留策略有多长)。问:重复数据删除的级别是多少? 答:我们在作业级别(不在作业之间)上使用常量块大小(可配置4096 KB,1024 KB,512

KB或256 KB块)阻止级别重复数据删除。如果存储库配置了“每个VM备份文件”,则重复数据删除将在每个VM级别上进行。问:我被告知Veeam重复数据删除效率低,因为它使用大块大小。 答:

Veeam重复数据删除旨在与压缩协同工作,因此您应该考虑整体数据缩减比率。大块大小允许更高的处理性能,并且对于各个块具有更好的压缩比。这使得Veeam能够以更小的处理开销实现相同的数据缩减因子。从这项研究中可以看出通过EMC,当重复数据删除与压缩相结合时,总体数据减少比率与块大小增加大致相同。这是因为压缩算法受益于块中有更多数据可供使用。问:如何实现最佳重复数据删除率?

答:在同一作业中对类似的VM(例如具有相同操作系统的VM或由相同模板制作的VM)进行分组。拥有更多虚拟机的作业更少,而每个虚拟机中的虚拟机更少。不要在存储库上配置“每个VM备份文件”。问:我的虚拟机不是由同一个模板制作的。将重复数据删除工作吗?

A:是。由于重复数据删除是在块级别上完成的,因此无论VM是由同一模板制作还是手动配置都无关紧要。即使这些VM具有不同的操作系统,也将重复删除VM之间的任何类似块。问:重复数据删除是否适用于复制或仅用于备份? 答:不可以,因为副本是以本机格式(未压缩)创建的,所以重复数据删除不适用于它们。

问:由于Veeam有自己的重复数据删除功能,将Veeam备份文件写入具有硬件重复数据删除功能的存储设备是否有意义?

A:是的,这样您就可以获得全局重复数据删除(在不同备份作业生成的备份文件之间)。一般来说,重复数据删除存储设备是Veeam生成的备份文件长期存档的最佳选择。大多数重复数据删除存储设备都不能作为主要备份目标,因为与原始磁盘不同,这些设备不能提供良好的IOPS,并且可能成为备份性能的主要瓶颈,从而影响备份窗口。同样,某些重复数据删除存储设备的随机读取I

/ O性能较差,可能会影响恢复性能。问:您是否已与其他供应商的重复数据删除技术(如EMC DataDomain,HP

StoreOnce,ExaGrid,Quantum等)进行了集成测试?

A:是的,我们与大多数重复数据删除存储供应商建立了合作关系。此外,许多版本都有明显的性能提升。问:我应该禁用内置重复数据删除吗?我要备份到重复数据删除设备吗?

答:如果您使用“Veeam集成”重复数据删除设备(带有DDboost的EMC Data Domain,ExaGrid,带催化剂的HPE

StoreOnce,Quantum

DXi),将根据最佳实践自动调整设置。有关其他重复数据删除设备或协议,请参阅最佳实践指南中的作业和存储库设置

问:节省的预期带宽是多少? 答:数据缩减率可达到原始大小的50倍甚至更多,但这取决于太多因素,例如内容的相似性。近似储蓄率可以假定为10倍

Q:使用带宽超过100 Mbit / s的WAN加速器是否有意义? 答:大多数情况下没有。根据环境的不同,您将看到不会以50-100Mbit

/ s或更高的带宽节省传输时间。但是,您仍然可以通过使用WAN加速器来节省带宽。问:应在目标WAN加速器上配置哪个缓存大小? A:建议为WAN加速器处理的每个操作系统(Windows 2012,2012R2,2016

...)配置10 GB的缓存大小。所有Linux发行版都算作一个操作系统问:应该在源WAN加速器上配置哪个缓存大小?

答:源WAN加速器上的全局缓存未使用,但必须以数字形式存在(最小5GB)。请记住,源WAN加速器每1 TB源数据需要大约20

GB来存储源VM磁盘数据块的摘要。磁盘空间消耗是动态的,并且在启用WAN加速的作业中添加(或删除)唯一VM时会发生更改

问:应用程序感知图像处理到底是什么意思?

答:应用程序感知图像处理是独特的Veeam技术,允许以应用程序感知方式创建映像级备份。这是一个多步骤过程,包括检测在已处理VM中运行的应用程序;

使用Microsoft VSS执行应用程序级别的静止,以确保每个应用程序状态在事务上保持一致;

应用特定于应用程序的设置,以准备每个应用程序在下次VM启动时执行VSS感知还原;

最后,如果备份成功,则对某些应用程序执行事务日志修剪。整个过程完全自动化。问:为什么Veeam中的应用程序感知图像处理功能很重要?它如何比VMware Tools VSS集成更好? 答: Microsoft

VSS的设计并未考虑图像级备份和还原,而是针对文件级备份和还原过程。对于某些应用程序,除了基本的VSS静止之外,还需要在备份和恢复整个VM映像时采取其他步骤。问:我是否需要在我备份的每个VM中部署持久代理,以便能够使用应用程序感知图像处理?

A:不,Veeam不在VM中使用持久代理。相反,Veeam会在备份开始时自动为每个VM部署小型运行时协调进程,并在备份完成后立即将其删除。这使您从代理微管理(部署,配置,更新,监视,故障排除)中解脱出来。此外,实际的VM在大多数时间没有任何第三方代理的情况下运行。问: Veeam是否为每位客人安装了自己的VSS提供商?

答:不,我们利用Microsoft的默认VSS提供程序,该提供程序已在每个Windows客户机上提供。问:什么是Microsoft VSS以及它如何通过映像级备份提供事务一致性? 答:请阅读以下Microsoft

VSS初学者指南:什么是Windows VSS以及您应该关注的原因问:您为事务一致性备份支持哪些应用程序? 答:在Windows XP /

2003或更高版本上运行的任何VSS感知应用程序。Microsoft的所有现代服务器应用程序都支持VSS,而且许多第三方供应商也将其服务器应用程序与VSS编写器一起提供。问:我如何知道我的应用程序是否支持VSS? 答:它应该实现VSS编写器并在Microsoft

VSS框架中安装和注册。在备份的VM上打开命令提示符,并运行vssadmin list

writer以获取特定系统上VSS感知应用程序的完整列表。问:你知道Oracle是否有VSS编写器吗? A:是的,Oracle 11g有一个名为“Oracle VSS

Writer”的组件,在Oracle 11g数据库安装向导中选择Windows

OCI组件时会安装该组件。它从补丁集10.2.0.3开始支持Oracle 10g。后来的版本(12c,18c)也有一个VSS编写器。

Windows

问:文件级恢复(FLR)是否要求在恢复之前提取并在磁盘或RAM中暂存备份文件内容? 答:不,文件级恢复直接来自备份文件,而不是事先提取。

问:是否必须备份启用了客户机文件系统索引的VM才能进行文件级恢复?

答:不可以。与其他解决方案不同,Veeam索引是完全可选的,不是文件级恢复的要求。但是,通过索引,您可以通过Web

UI另外执行1-Click File Restore(请参见下文)。问:本机Windows文件级恢复如何工作?

A:本机Windows文件级恢复将备份文件的内容直接挂载到备份服务器作为文件夹。您甚至可以将任何应用程序指向位于这些文件夹中的文件,并正常使用它们(无论您做什么,备份文件都是只读的)。问:您可以使用正确的权限还原文件吗? 答:可以,此选项现已推出。

问:即时文件级恢复支持哪些文件系统? 答: FAT,NTFS和ReFS。

问:是否支持GPT磁盘? 答:可以,从6.1开始

问:是否支持Windows动态磁盘? 答:是的,启动6.5版

其他操作系统

问:多OS文件级恢复如何工作?

答:由于Windows本身不能读取其他文件系统,我们发明了一种正在申请专利的方法,该方法使用特殊的FLR辅助设备,运行剥离Linux(需要10秒才能启动),但足够智能,能够从多个读取数据17个文件系统。您要还原的VM的虚拟磁盘文件直接从备份文件挂载到FLR帮助程序设备(无需事先提取)。问:您可以使用正确的权限还原文件吗? 答:是的,当直接还原到Linux主机时,此选项现在可在多操作系统文件级还原向导中使用。

问:即时文件级恢复支持哪些操作系统?

A:17种最常用的文件系统,分别来自Windows,Linux,Solaris,BSD,Unix,Novell和Mac操作系统。问:您是否支持从Novell / Micro Focus OES上的NSS卷进行即时文件级恢复?

答:是的。请参阅发行说明或用户指南中支持的文件系统的完整列表1 - 单击文件还原(企业管理器Web UI)

问:我是否已禁用1-Click文件还原按钮(还原和下载)?所有作业都启用了访客系统索引。

答:这是高级功能,仅在我们产品的企业版中提供。如果您有Standard Edition,请改用B&R控制台中的即时文件级恢复向导。问: 1-Click File Restore如何工作? 答:企业管理器Web

UI用户通过浏览或搜索备份VM的guest虚拟机文件系统索引来选择要还原的一个或多个guest虚拟机文件(索引解释如下)。然后,Enterprise

Manager在备份服务器上创建任务,备份服务器使用本机文件级还原功能还原文件(请参见上文)。问:我是否需要在guest虚拟机上安装任何代理才能将文件还原到原始位置? 答:不,1-Click文件还原是无代理的。

问:是否必须备份启用了客户机文件系统索引的VM才能启用1-Click File Restore?

答:是的,1-Click文件还原要求在备份期间对来宾文件系统编制索引。问:1-Click File Restore进程是保留原始文件还是只是覆盖它? 答:是的,原始文件使用_original后缀保留。

问:如果某个进程锁定了原始文件,并且无法重命名该怎么办?

答:在这种情况下,我们使用_restored后缀恢复文件,并记录警告否通知恢复操作员。问:如何让某人成为文件还原操作员? 答:使用企业管理器的“配置”页面,为用户授予相应的角色。然后,用户将能够登录到企业管理器Web

UI。文件还原操作员只能看到Web UI的子集(特别是“文件”选项卡)。问:文件还原操作员是否需要具有已还原文件,来宾,VM或主机的权限才能执行就地还原? 答:不可以。

问:我可以限制文件还原操作员只能恢复特定的文件类型吗?禁用下载还原文件的功能?仅限于某些虚拟机? 答:可以,企业管理器配置中提供了这些设置。

问:如果是就地恢复(回到原始位置),您是否保留文件权限和所有权? 答:是的。

问: 1-Click File Restore有哪些系统要求? A:与Windows文件级还原(见上文)相同,因为两者都使用相同的引擎。

问: Windows以外的操作系统是否支持1-Click File Restore?

答:与Windows文件级还原(见上文)相同,因为两者都使用相同的引擎。

问:我是否需要在每个VM内部部署任何代理才能索引来宾文件系统?

答:不需要代理商。您只需在备份作业向导中选中相应的复选框,然后指定管理员对VM的凭据。问:打开索引会显着减慢我的备份速度吗? A:通常不是。我们不是扫描整个文件系统(就像一些竞争解决方案那样),而是直接从NTFS

MFT捕获索引数据,作为客户操作系统冻结过程的一部分。对于典型的VM,几乎可以立即捕获和解析所需的数据,我们称之为即时索引。问: Instant Indexing功能是否仅适用于Veeam Enterprise Manager? 答:您不需要Enterprise

Manager来创建本地目录,但您必须安装Enterprise

Manager服务器才能在VM备份中浏览和搜索guest虚拟机文件,并在多个备份服务器上维护全局编录。另外,请参阅参考资料下产品页面上的标准版与企业版比较文档有关即时索引功能集的细微差别的详细信息,请参阅此选项卡,具体取决于您的Veeam

Backup许可级别。问:我有多个备份服务器。来宾文件搜索是否会在所有备份服务器上显示结果? 答:可以,只要所有备份服务器都在企业管理器中联合。

问:索引数据库在哪里? 答:本地目录直接存储在Veeam

Backup服务器上,在安装过程中指定的位置。全局编录(跨所有备份服务器)位于企业管理器服务器上。此外,索引也存储在备份文件本身中(因此它可立即用于所有导入的备份)。问:我需要备份什么才能保护索引数据库? 答:您需要备份企业管理器服务器,因为这是保存全局目录(跨所有备份服务器)。不需要在Veeam

Backup服务器上备份本地目录数据,因为在那里出现的任何新索引数据都会自动(并递增地)复制到全局编录。问:看起来客人文件索引缺少一些文件? 答:默认情况下,我们不会将Windows系统和临时文件夹编入索引以减小索引大小。

本文转载自veeam 官方kb

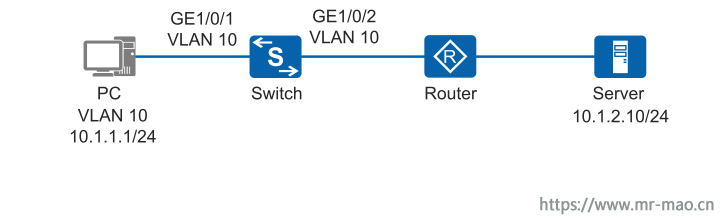

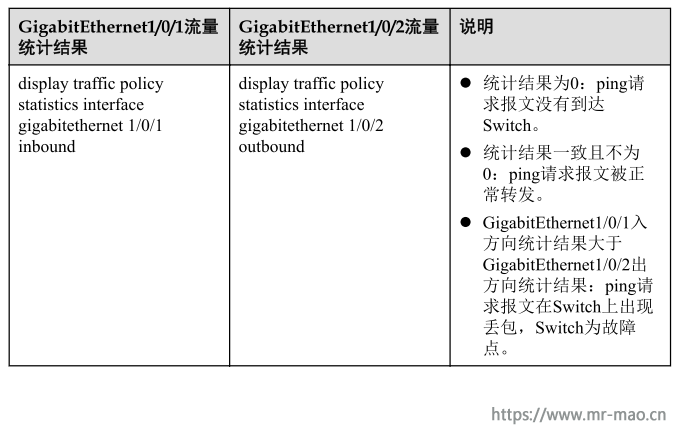

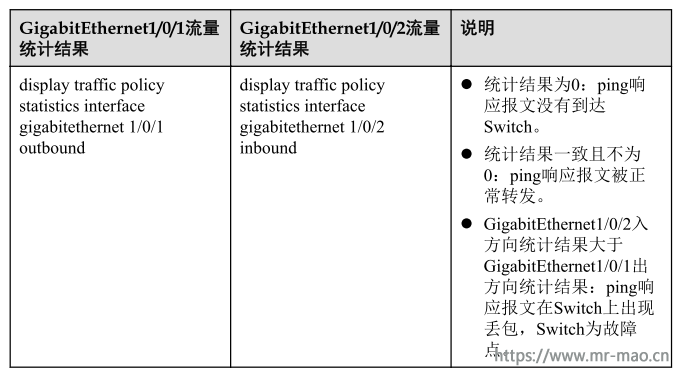

在处理网络故障的时候会出现设备之间无法ping通的情况,可以通过配置ping报文的流量统计来缩小故障范围,快速定位故障点。ping使用的是ICMP协议,因此可以在高级ACL的规则中通过匹配ICMP协议来定义数据流。配置流策略对ping报文进行流量统计时,按照ACL对报文进行分类,然后对匹配的报文进行流量统计。流量统计结果可以用于帮助定位故障。

A,如果设备上收到和转发的ping报文数量相等,表示ping报文被正常转发,设备上没有丢包;如果收到的ping报文比转发的ping报文多,表示设备上出现丢包。

B,如果设备接口上发送的ping报文与收到的ping报文数量相等,表示接口所在链路上没有丢包;如果设备接口上发送的ping报文比收到的ping报文多,表示接口所在链路上出现丢包,需要在对端设备上配置流量统计进行故障定位。

如图所示,PC无法访问Server,需要在数据流经过的设备配置ping报文流量统计来定位问题故障点。

配置思路

采用如下的思路配置ping报文的流量统计:

操作步骤

步骤1 创建VLAN并配置各接口

配置Switch。

<HUAWEI> system-view

[HUAWEI] sysname Switch

[Switch] vlan 10 //创建VLAN 10

[Switch-vlan10] quit

[Switch] interface gigabitethernet 1/0/1

[Switch-GigabitEthernet1/0/1] port link-type access //设置接口接入类型为access

[Switch-GigabitEthernet1/0/1] port default vlan 10 //将接口划分到VLAN 10

[Switch-GigabitEthernet1/0/1] quit

[Switch] interface gigabitethernet 1/0/2

[Switch-GigabitEthernet1/0/2] port link-type access

[Switch-GigabitEthernet1/0/2] port default vlan 10

[Switch-GigabitEthernet1/0/2] quit在路由器与Switch相连的接口上配置PC的网关地址10.1.1.2/24,路由器与Server相连的接口上配置IP地址10.1.2.1/24。

步骤2 配置ACL

# 在Switch上配置ACL规则,匹配PC和Server之间的ICMP报文。

[Switch] acl 3001

[Switch-acl-adv-3001] rule permit icmp source 10.1.1.1 0 destination 10.1.2.10 0 //匹配从PC到Server的ping报文

[Switch-acl-adv-3001] quit

[Switch] acl 3002

[Switch-acl-adv-3002] rule permit icmp source 10.1.2.10 0 destination 10.1.1.1 0 //配置从Server到PC的ping报文

[Switch-acl-adv-3002] quit步骤3 配置流分类

# 在Switch上配置流分类,按照ACL对报文进行分类。

[Switch] traffic classifier c1 operator and

[Switch-classifier-c1] if-match acl 3001

[Switch-classifier-c1] quit

[Switch] traffic classifier c2 operator and

[Switch-classifier-c2] if-match acl 3002

[Switch-classifier-c2] quit步骤4 配置流行为

# 在Switch上配置流行为,动作为流量统计。

[Switch] traffic behavior b1

[Switch-behavior-b1] statistic enable

[Switch-behavior-b1] quit

[Switch] traffic behavior b2

[Switch-behavior-b2] statistic enable

[Switch-behavior-b2] quit步骤5 配置流策略并应用到接口

在Switch上创建流策略p1和p2,将流分类和对应的流行为进行绑定,并将流策略p1应

用到接口GE1/0/1的入方向和GE1/0/2的出方向上,将流策略p2应用到接口GE1/0/1的出

方向和GE1/0/2的入方向上。

[Switch] traffic policy p1

[Switch-trafficpolicy-p1] classifier c1 behavior b1

[Switch-trafficpolicy-p1] quit

[Switch] traffic policy p2

[Switch-trafficpolicy-p2] classifier c2 behavior b2

[Switch-trafficpolicy-p2] quit

[Switch] interface gigabitethernet 1/0/1

[Switch-GigabitEthernet1/0/1] traffic-policy p1 inbound

[Switch-GigabitEthernet1/0/1] traffic-policy p2 outbound

[Switch-GigabitEthernet1/0/1] quit

[Switch] interface gigabitethernet 1/0/2

[Switch-GigabitEthernet1/0/2] traffic-policy p1 outbound

[Switch-GigabitEthernet1/0/2] traffic-policy p2 inbound

[Switch-GigabitEthernet1/0/2] quit步骤6 验证配置结果

# 在Switch上查看ACL规则的配置信息。

[Switch] display acl all

Total nonempty ACL number is 2

Advanced ACL 3001, 1 rule

Acl's step is 5

rule 5 permit icmp source 10.1.1.1 0 destination 10.1.2.10 0 (match-counter 0)

Advanced ACL 3002, 1 rule

Acl's step is 5

rule 5 permit icmp source 10.1.2.10 0 destination 10.1.1.1 0 (match-counter 0)

# 在Switch上查看流策略的配置信息。

[Switch] display traffic policy user-defined

User Defined Traffic Policy Information:

Policy: p2

Classifier: c2

Operator: AND

Behavior: b2

Permit

Statistic: enable

Policy: p1

Classifier: c1

Operator: AND

Behavior: b1

Permit

Statistic: enable

Total policy number is 2在PC上ping Server,然后在Switch上查看接口GE1/0/1及GE1/0/2的入方向和出方向的

流量统计结果。这里以查看接口GE1/0/1入方向的流量统计结果为例。

[Switch] display traffic policy statistics interface gigabitethernet 1/0/1 inbound

Interface: GigabitEthernet1/0/1

Traffic policy inbound: p1

Rule number: 1

Current status: success

Statistics interval: 300

---------------------------------------------------------------------

Board : 1

---------------------------------------------------------------------

Matched | Packets: 0

| Bytes: 0

| Rate(pps): 0

| Rate(bps): 0

---------------------------------------------------------------------

Passed | Packets: 0

| Bytes: 0

| Rate(pps): 0

| Rate(bps): 0

---------------------------------------------------------------------

Dropped | Packets: 0

| Bytes: 0

| Rate(pps): 0

| Rate(bps): 0

---------------------------------------------------------------------

Filter | Packets: 0

| Bytes: 0

---------------------------------------------------------------------

Car | Packets: 0

| Bytes: 0

---------------------------------------------------------------------回显信息中,Matched显示匹配流分类规则的报文数和字节数,Passed显示匹配流分类

规则的报文中通过的报文数和字节数。流量统计结果的具体分析如下表所示。

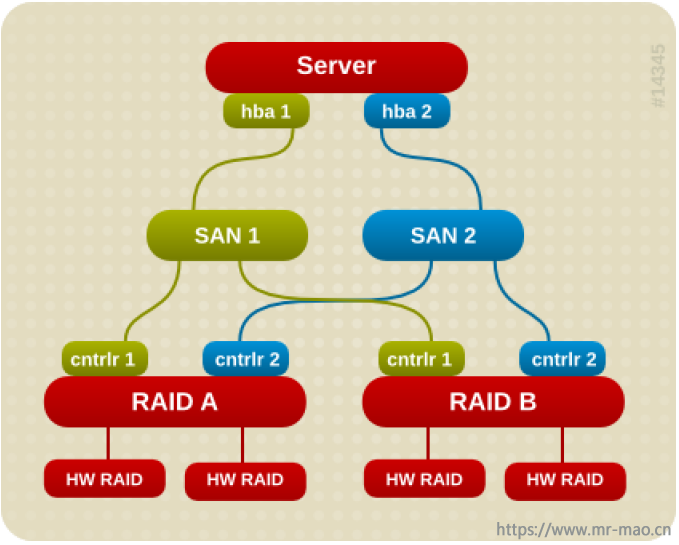

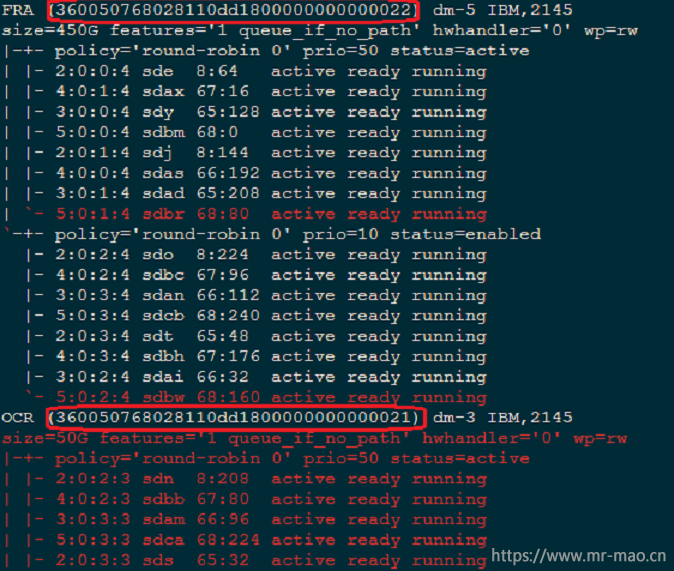

一,安装软件

1,执行以下命令,检查当前系统中是否已经安装多路径工具:

rpm -qa | grep device-mapper-multipath SuSE 系统 multipath 相关 rpm 包是 multipath-tools-*.rpm,检查安装包时使用如下命令:

rpm -qa | grep multipath 2,如果配置好了yum执行下面的命令安装,没有yum看第3步

yum install -y device-mapper device-mapper-multipath3,从系统安装盘的/Packages 文件夹中拷出下面两个文件,执行命令安装,不同的linux发行版,多路径软件的版本号不同,

rpm -ivh device-mapper-multipath-libs-0.4.9-80.el6.x86_64.rpm

rpm -ivh device-mapper-multipath-0.4.9-80.el6.x86_64.rpm 4,完成以上步骤后,需检查多路径工具是否已经安装成功。请执行以下命令:

rpm -qa | grep device-mapper-multipath SuSE 系统 multipath 相关 rpm 包是 multipath-tools-*.rpm,检查安装包时使用如下命令:

rpm -qa | grep multipath

二,配置DM Multipath

逐步执行以下命令加载内核 device-mapper 模块,并启动 multipathd 服务。

modprobe dm-multipath

modprobe dm-service-time

service multipathd start (RHEL6.x、CentOS6.x、SuSE)

systemctl start multipathd.service (RHEL7.x、CentOS7.x) 说明:在本博客的<存储>分类下,有介绍linux不用重启扫描磁盘的文章,有兴趣可以参考

三,获取多路径信息

1,执行下面命令生成多路径配置文件

mpathconf --enable2,删除当前没有使用的多路径

multipath -F3,格式化、检测、合并多路径

multipath -v24,查看多路径状态

multipath -ll下面这段来自于网络,我写这个文档是根据自己的经验写,没有现场设备截图。

[root@server /]# multipath -ll

mpathc (3600a0b80001ffaf20000297a583cfaea) dm-5 IBM ,1722-600

size=84G features='1 queue_if_no_path' hwhandler='1 rdac' wp=rw

|-+- policy='service-time 0' prio=6 status=active

| |- 1:0:1:2 sdg 8:96 active ready running

| `- 6:0:1:2 sdm 8:192 active ready running

`-+- policy='service-time 0' prio=1 status=enabled

|- 1:0:0:2 sdd 8:48 active ghost running

`- 6:0:0:2 sdj 8:144 active ghost running

mpathb (3600a0b80002109ed0000174c583c8ba5) dm-4 IBM ,1722-600

size=70G features='1 queue_if_no_path' hwhandler='1 rdac' wp=rw

|-+- policy='service-time 0' prio=6 status=active

| |- 1:0:0:1 sdc 8:32 active ready running

| `- 6:0:0:1 sdi 8:128 active ready running

`-+- policy='service-time 0' prio=1 status=enabled

|- 1:0:1:1 sdf 8:80 active ghost running

`- 6:0:1:1 sdl 8:176 active ghost running

mpatha (3600a0b80001ffaf200002978583cfabc) dm-3 IBM ,1722-600

size=50G features='1 queue_if_no_path' hwhandler='1 rdac' wp=rw

|-+- policy='service-time 0' prio=6 status=active

| |- 1:0:1:0 sde 8:64 active ready running

| `- 6:0:1:0 sdk 8:160 active ready running此时记录mpath磁盘的wwid,下面要用到

四,配置多路径文件

1,创建multipath.conf

vi /etc/multipath.conf 编辑内容如下,这只是一个范本,大家根据自己的环境定义wwid和alias。

blacklist{

devnode sda

}

defaults{

find_multipaths yes

user_friendly_names yes

failback immediate

path_selector "round-robin 0"

path_checker tur

path_grouping_policy multibus

prio alua

}

multipaths {

multipath {

wwid 3600c0ff00029769ea010bc5901000000

alias MBXT_OCR

multipath {

wwid 3600c0ff00029769ea310bc5901000000

alias MBXT_DATA1

}

multipath {

wwid 3600c0ff00029769ea410bc5901000000

alias MBXT_DATA2

multipath {

wwid 3600c0ff00029769ea410bc5901000000

alias MBXT_FRA

}

}保存以后执行

service multipathd restart (RHEL6.x、CentOS6.x、SuSE)

systemctl restart multipathd.service(RHEL7.x、CentOS7.x)

说明:

a,上面示例的wwid就是执行multipath ll之后记录的每个磁盘的id,根据自己的硬件环境编辑即可

b,alias 是友好别名,根据自己的使用环境定义即可

c,blacklist里的sda,不扫描本地磁盘,这里根据本地磁盘盘符来确定,该示例中假定本地盘符为 sda

d,有些存储不支持prio alua,重启多路径服务的时候会报错,重新编辑multipath.conf把prio alua 这一行删除即可。

e,每次编辑完multipath.conf 都必需重启multipathd服务

2,把multipathd 服务加入开机自启动

chkconfig --level 35 multipathd on (RHEL6.x、CentOS6.x、SuSE)

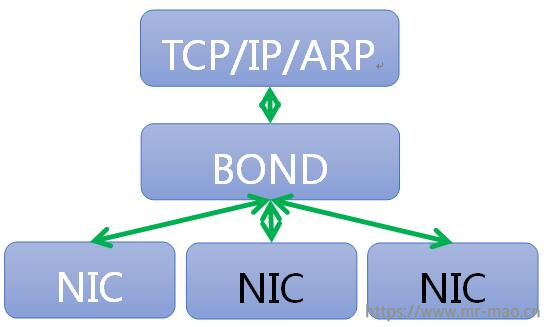

systemctl enable multipathd.service (RHEL7.x、CentOS7.x) 在我们日常Linux使用中,一般对于生产网都会使用双网卡或多网卡接入,这样既能添加网络带宽,同时又能做相应的冗余,可谓好处多多。而一般我们都会使用Linux操作系统下自带的网卡绑定模式。这一点不像Windows2008,操作系统没有网卡绑定功能,需要网卡产商针对windows操作系统定制网卡管理软件来做网卡绑定(windows2012操作系统中加入了网卡绑定功能)。

下面的绑定教程适用于Redhat和Centos 6系列和7系列版本

:

此模式不需要在交换机做配置,即配即用

备份要配置的网卡文件,我在这里要配置eno1和eno2,

[root@server ~]# cd /etc/sysconfig/network-scripts/

[root@server network-scripts]# ls

ifcfg-eno1 ifdown ifdown-routes ifup-ib ifup-sit

ifcfg-eno2 ifdown-bnep ifdown-sit ifup-ippp ifup-Team

ifcfg-enp0s20f0u1u6 ifdown-eth ifdown-Team ifup-ipv6 ifup-TeamPort

ifcfg-enp175s0f0 ifdown-ib ifdown-TeamPort ifup-isdn ifup-tunnel

ifcfg-enp175s0f1 ifdown-ippp ifdown-tunnel ifup-plip ifup-wireless

ifcfg-enp6s0f0 ifdown-ipv6 ifup ifup-plusb init.ipv6-global

ifcfg-enp6s0f1 ifdown-isdn ifup-aliases ifup-post network-functions

ifcfg-enp6s0f1.bak ifdown-post ifup-bnep ifup-ppp network-functions-ipv6

ifcfg-lo ifdown-ppp ifup-eth ifup-routes

[root@server network-scripts]# cp ifcfg-eno1 ifcfg-eno1.bak

[root@server network-scripts]# cp ifcfg-eno2 ifcfg-eno2.bak

[root@server network-scripts]# 分别编辑两个网卡的文件

先编辑ifcfg-eno1

[root@server network-scripts]# vi ifcfg-eno1

[root@server network-scripts]# cat ifcfg-eno1

DEVICE=eno1

BOOTPROTO=none

ONBOOT=yes

MASTER=bond0

SLAVE=yes

USERCTL=no

NM_CONTROLLED=no再编辑ifcfg-eno2

[root@server network-scripts]# vi ifcfg-eno2

[root@server network-scripts]# cat ifcfg-eno2

DEVICE=eno2

BOOTPROTO=none

ONBOOT=yes

MASTER=bond0

SLAVE=yes

USERCTL=no

NM_CONTROLLED=no最后新建bond0文件

[root@server network-scripts]# vi ifcfg-bond0

[root@server network-scripts]# cat ifcfg-bond0

DEVICE=bond0

ONBOOT=yes

BOOTPROTO=static

IPADDR=192.168.1.100

NETMASK=255.255.255.0

GATEWAY=192.168.1.1

USERCTL=no

NM_CONTROLLED=no

BONDING_OPTS="mode=1 primary=eno1 miimon=100"配置完成以后

6系列版本执行:service network restart

7系列版本执行:systemctl restart network此模式需要在交换机上配置802.3ad 链路聚合,此模式也是真正的负载均衡模式,在分布式和高性能场景使用较多

备份要配置的网卡文件,我在这里要配置eno1和eno2,

[root@server ~]# cd /etc/sysconfig/network-scripts/

[root@server network-scripts]# ls

ifcfg-eno1 ifdown ifdown-routes ifup-ib ifup-sit

ifcfg-eno2 ifdown-bnep ifdown-sit ifup-ippp ifup-Team

ifcfg-enp0s20f0u1u6 ifdown-eth ifdown-Team ifup-ipv6 ifup-TeamPort

ifcfg-enp175s0f0 ifdown-ib ifdown-TeamPort ifup-isdn ifup-tunnel

ifcfg-enp175s0f1 ifdown-ippp ifdown-tunnel ifup-plip ifup-wireless

ifcfg-enp6s0f0 ifdown-ipv6 ifup ifup-plusb init.ipv6-global

ifcfg-enp6s0f1 ifdown-isdn ifup-aliases ifup-post network-functions

ifcfg-enp6s0f1.bak ifdown-post ifup-bnep ifup-ppp network-functions-ipv6

ifcfg-lo ifdown-ppp ifup-eth ifup-routes

[root@server network-scripts]# cp ifcfg-eno1 ifcfg-eno1.bak

[root@server network-scripts]# cp ifcfg-eno2 ifcfg-eno2.bak

分别编辑两个网卡的文件

先编辑ifcfg-eno1

[root@server network-scripts]# vi ifcfg-eno1

[root@server network-scripts]# cat ifcfg-eno1

DEVICE=eno1

BOOTPROTO=none

ONBOOT=yes

MASTER=bond0

SLAVE=yes

USERCTL=no

NM_CONTROLLED=no再编辑ifcfg-eno2

[root@server network-scripts]# vi ifcfg-eno2

[root@server network-scripts]# cat ifcfg-eno2

DEVICE=eno2

BOOTPROTO=none

ONBOOT=yes

MASTER=bond0

SLAVE=yes

USERCTL=no

NM_CONTROLLED=no最后新建bond0文件,ip地址信息根据环境自定义

[root@server network-scripts]# vi ifcfg-bond0

[root@server network-scripts]# cat ifcfg-bond0

DEVICE=bond0

ONBOOT=yes

BOOTPROTO=static

IPADDR=192.168.1.100

NETMASK=255.255.255.0

GATEWAY=192.168.1.1

USERCTL=no

NM_CONTROLLED=no

BONDING_OPTS="mode=4 miimon=100 xmit_hash_policy=layer2+3"配置完成以后6系列版本执行:service network restart

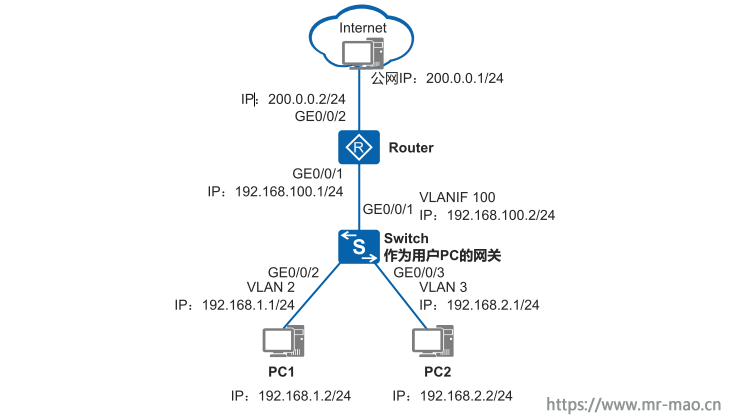

7系列版本执行:systemctl restart network三层交换机是具有路由功能的交换机,由于路由属于OSI模型中第三层网络层的功能,所以称为三层交换机。

三层交换机既可以工作在二层也可以工作在三层,可以部署在接入层,也可以部署在汇聚层,作为用户的网关。

如图所示,某公司拥有多个部门且位于不同网段,各部门均有访问Internet的需求。现要求用户通过三层交换机和路由器访问外部网络,且要求三层交换机作为用户的网关。

此章节摘自于华为官方文档,我做过类似的项目,所以放这里,以便以后查看

配置思路

采用如下思路进行配置:

配置连接用户的接口和对应的VLANIF接口。

<HUAWEI> system-view

[HUAWEI] sysname Switch

[Switch] vlan batch 2 3

[Switch] interface gigabitethernet 0/0/2

[Switch-GigabitEthernet0/0/2] port link-type access //配置接口接入类型为access

[Switch-GigabitEthernet0/0/2] port default vlan 2 //配置接口加入VLAN 2

[Switch-GigabitEthernet0/0/2] quit

[Switch] interface gigabitethernet 0/0/3

[Switch-GigabitEthernet0/0/3] port link-type access

[Switch-GigabitEthernet0/0/3] port default vlan 3

[Switch-GigabitEthernet0/0/3] quit

[Switch] interface vlanif 2

[Switch-Vlanif2] ip address 192.168.1.1 24

[Switch-Vlanif2] quit

[Switch] interface vlanif 3

[Switch-Vlanif3] ip address 192.168.2.1 24

[Switch-Vlanif3] quit配置连接路由器的接口和对应的VLANIF接口。

[Switch] vlan batch 100

[Switch] interface gigabitethernet 0/0/1

[Switch-GigabitEthernet0/0/1] port link-type access

[Switch-GigabitEthernet0/0/1] port default vlan 100

[Switch-GigabitEthernet0/0/1] quit

[Switch] interface vlanif 100

[Switch-Vlanif100] ip address 192.168.100.2 24

[Switch-Vlanif100] quit配置缺省路由。

[Switch] ip route-static 0.0.0.0 0.0.0.0 192.168.100.1 //缺省路由的下一跳是路由器接口的IP地址192.168.100.1配置DHCP服务器。

[Switch] dhcp enable

[Switch] interface vlanif 2

[Switch-Vlanif2] dhcp select interface //DHCP使用接口地址池的方式为用户分配IP地址

[Switch-Vlanif2] dhcp server dns-list 114.114.114.114 223.5.5.5 //配置的DNS-List 114.114.114.114是公用的DNS服务器地址,是不区分运营商的。在实际应用中,请根据运营商分配的DNS进行配置

[Switch-Vlanif2] quit

[Switch] interface vlanif 3

[Switch-Vlanif3] dhcp select interface

[Switch-Vlanif3] dhcp server dns-list 114.114.114.114 223.5.5.5

[Switch-Vlanif3] quit步骤2 配置路由器

配置连接交换机的接口对应的IP地址。

<Huawei> system-view

[Huawei] sysname Router

[Router] interface gigabitethernet 0/0/1

[Router-GigabitEthernet0/0/1] ip address 192.168.100.1 255.255.255.0 //配置的IP地址

192.168.100.1为交换机缺省路由的下一跳IP地址

[Router-GigabitEthernet0/0/1] quit配置连接公网的接口对应的IP地址。

[Router] interface gigabitethernet 0/0/2

[Router-GigabitEthernet0/0/2] ip address 200.0.0.2 255.255.255.0 //配置连接公网接口的IP地址和公网的IP地址在同一网段

[Router-GigabitEthernet0/0/2] quit配置缺省路由和回程路由。

[Router] ip route-static 0.0.0.0 0.0.0.0 200.0.0.1 //配置静态缺省路由的下一跳指向公网提供的IP地址200.0.0.1

[Router] ip route-static 192.168.0.0 255.255.0.0 192.168.100.2 //配置回程路由的下一跳就指向交换机上行接口的IP地址192.168.100.2配置NAT功能,使内网用户可以访问外网。

[Router] acl number 2001

[Router-acl-basic-2001] rule 5 permit source 192.168.0.0 0.0.255.255 //NAT转换只对源IP地址是192.168.0.0/16网段的生效,并在接口GE0/0/2的出方向进行转换

[Router-acl-basic-2001] quit

[Router] interface gigabitethernet 0/0/2

[Router-GigabitEthernet0/0/2] nat outbound 2001

[Router-GigabitEthernet0/0/2] quit步骤3 检查配置结果

配置PC1的IP地址为192.168.1.2/24,网关为192.168.1.1;PC2的IP地址为

192.168.2.2/24,网关为192.168.2.1。

配置外网PC的IP地址为200.0.0.1/24,网关为200.0.0.2。

配置完成后,PC1和PC2都可以Ping通外网的IP 200.0.0.1/24,PC1和PC2都可以访问

Internet。

----结束

配置文件

l Switch的配置文件

#

sysname Switch

#

vlan batch 2 to 3 100

#

dhcp enable

#

interface Vlanif2

ip address 192.168.1.1 255.255.255.0

dhcp select interface

dhcp server dns-list 114.114.114.114 223.5.5.5

#

interface Vlanif3

ip address 192.168.2.1 255.255.255.0

dhcp select interface

dhcp server dns-list 114.114.114.114 223.5.5.5

#

interface Vlanif100

ip address 192.168.100.2 255.255.255.0

#

interface GigabitEthernet0/0/1

port link-type access

port default vlan 100

#

interface GigabitEthernet0/0/2

port link-type access

port default vlan 2

#

interface GigabitEthernet0/0/3

port link-type access

port default vlan 3

#

ip route-static 0.0.0.0 0.0.0.0 192.168.100.1

#

return

l Router的配置文件

#

sysname Router

#

acl number 2001

rule 5 permit source 192.168.0.0 0.0.255.255

#

interface GigabitEthernet0/0/1

ip address 192.168.100.1 255.255.255.0

#

interface GigabitEthernet0/0/2

ip address 200.0.0.2 255.255.255.0

nat outbound 2001

#

ip route-static 0.0.0.0 0.0.0.0 200.0.0.1

ip route-static 192.168.0.0 255.255.0.0 192.168.100.2

#

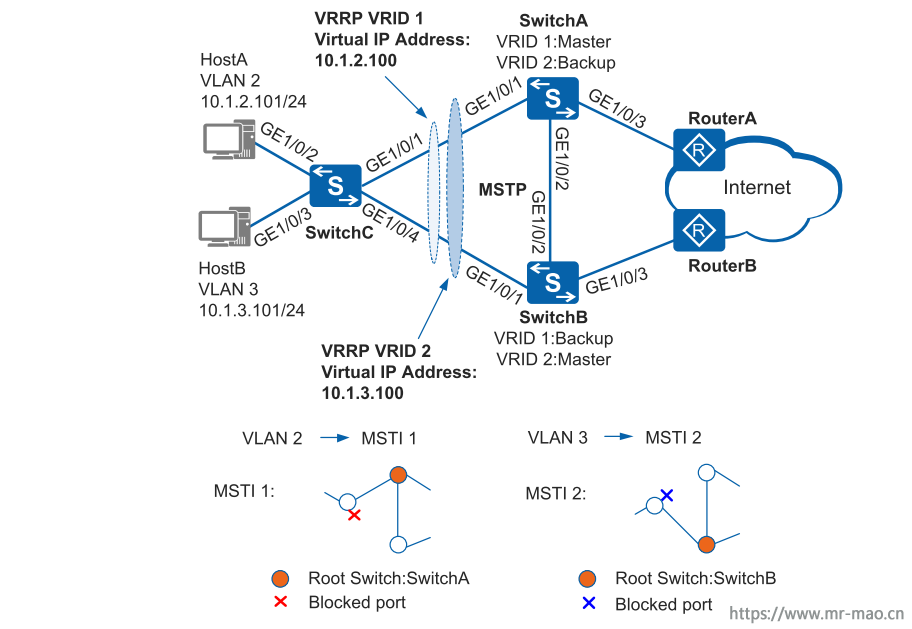

return网络中部署VRRP负载分担时,多台设备同时承担业务,每个虚拟设备都包括一个Master设备和若干个Backup设备。如果为了接入备份需要同时部署冗余链路,则需要部署MSTP消除网络中的环路,保证流量的负载分担。

如图所示,主机通过SwitchC接入网络,SwitchC通过双上行连接SwitchA和SwitchB来接入Internet。由于接入备份的需要,用户部署了冗余链路。冗余备份链路的存在导致出现环网,可能会引起广播风暴和MAC地址表项被破坏。用户希望在存在冗余备份链路的同时消除网络中的环路,在一条上行链路断开的时候,流量能切换到另外一条上行链路转发,还能合理利用网络带宽。此时可以在网络中部署MSTP解决环路问题。MSTP可阻塞二层网络中的冗余链路,将网络修剪成树状,达到消除环路的目的。同时在SwitchA和SwitchB上配置VRRP,HostA以SwitchA为默认网关接入Internet,SwitchB作为备份网关;HostB以SwitchB为默认网关接入Internet,SwitchA作为备份网关,以实现可靠性及流量的负载分担。

此章节摘自于华为官方文档,我做过类似的项目,所以放这里,以便以后查看。

采用以下思路配置:

配置SwitchA、SwitchB、SwitchC到域名为RG1的域内,创建实例MSTI1和实例

MSTI2

配置SwitchA的MST域。

<HUAWEI> system-view

[HUAWEI] sysname SwitchA

[SwitchA] stp region-configuration //进入MST域视图。

[SwitchA-mst-region] region-name RG1 //配置域名为RG1。

[SwitchA-mst-region] instance 1 vlan 2 //将VLAN 2映射到实例1上。

[SwitchA-mst-region] instance 2 vlan 3 //将VLAN 3映射到实例2上。

[SwitchA-mst-region] active region-configuration //激活MST域的配置。

[SwitchA-mst-region] quit配置SwitchB的MST域。

<HUAWEI> system-view

[HUAWEI] sysname SwitchB

[SwitchB] stp region-configuration //进入MST域视图。

[SwitchB-mst-region] region-name RG1 //配置域名为RG1。

[SwitchB-mst-region] instance 1 vlan 2 //将VLAN 2映射到实例1上。

[SwitchB-mst-region] instance 2 vlan 3 //将VLAN 3映射到实例2上。

[SwitchB-mst-region] active region-configuration //激活MST域的配置。

[SwitchB-mst-region] quit配置SwitchC的MST域。

<HUAWEI> system-view

[HUAWEI] sysname SwitchC

[SwitchC] stp region-configuration //进入MST域视图。

[SwitchC-mst-region] region-name RG1 //配置域名为RG1。

[SwitchC-mst-region] instance 1 vlan 2 //将VLAN 2映射到实例1上。

[SwitchC-mst-region] instance 2 vlan 3 //将VLAN 3映射到实例2上。

[SwitchC-mst-region] active region-configuration //激活MST域的配置。

[SwitchC-mst-region] quit在域RG1内,配置MSTI1与MSTI2的根桥与备份根桥

– 配置MSTI1的根桥与备份根桥

# 配置SwitchA为MSTI1的根桥。

[SwitchA] stp instance 1 root primary

# 配置SwitchB为MSTI1的备份根桥。

[SwitchB] stp instance 1 root secondary

– 配置MSTI2的根桥与备份根桥

# 配置SwitchB为MSTI2的根桥。

[SwitchB] stp instance 2 root primary

# 配置SwitchA为MSTI2的备份根桥。

[SwitchA] stp instance 2 root secondary配置实例MSTI1和MSTI2中将要被阻塞端口的路径开销值大于缺省值

说明

– 端口路径开销值取值范围由路径开销计算方法决定,这里选择使用华为计算方法为例,

配置实例MSTI1和MSTI2中将被阻塞端口的路径开销值为20000。

– 同一网络内所有交换设备的端口路径开销应使用相同的计算方法。

# 配置SwitchA的端口路径开销计算方法为华为计算方法。

[SwitchA] stp pathcost-standard legacy

# 配置SwitchB的端口路径开销计算方法为华为计算方法。

[SwitchB] stp pathcost-standard legacy

#配置SwitchC的端口路径开销计算方法为华为计算方法,将端口GE1/0/1在实例MSTI2中的路径开销值配置为20000,将端口GE1/0/4在实例MSTI1中的路径开销值配置为20000。

[SwitchC] stp pathcost-standard legacy

[SwitchC] interface gigabitethernet 1/0/1

[SwitchC-GigabitEthernet1/0/1] stp instance 2 cost 20000

[SwitchC-GigabitEthernet1/0/1] quit

[SwitchC] interface gigabitethernet 1/0/4

[SwitchC-GigabitEthernet1/0/4] stp instance 1 cost 20000

[SwitchC-GigabitEthernet1/0/4] quit使能MSTP,实现破除环路

– 设备全局使能MSTP

# 在SwitchA上启动MSTP。

[SwitchA] stp enable

# 在SwitchB上启动MSTP。

[SwitchB] stp enable

# 在SwitchC上启动MSTP。

[SwitchC] stp enable– 将与Host相连的端口配置为边缘端口

[SwitchC] interface gigabitethernet 1/0/2

[SwitchC-GigabitEthernet1/0/2] stp edged-port enable

[SwitchC-GigabitEthernet1/0/2] quit

[SwitchC] interface gigabitethernet 1/0/3

[SwitchC-GigabitEthernet1/0/3] stp edged-port enable

[SwitchC-GigabitEthernet1/0/3] quit

(可选)配置SwitchC的BPDU保护功能。

[SwitchC] stp bpdu-protection– 将与Router相连的端口配置为边缘端口

# 配置SwitchA端口。

[SwitchA] interface gigabitethernet 1/0/3

[SwitchA-GigabitEthernet1/0/3] stp edged-port enable

[SwitchA-GigabitEthernet1/0/3] quit

(可选)配置SwitchA的BPDU保护功能。

[SwitchA] stp bpdu-protection# 配置SwitchB端口。

[SwitchB] interface gigabitethernet 1/0/3

[SwitchB-GigabitEthernet1/0/3] stp edged-port enable

[SwitchB-GigabitEthernet1/0/3] quit

(可选)配置SwitchB的BPDU保护功能。

[SwitchB] stp bpdu-protection说明

如果与边缘端口相连的是使能了STP功能的网络设备,配置BPDU保护功能后,如果

边缘端口收到BPDU报文,边缘端口将会被shutdown,边缘端口属性不变。

步骤2 配置保护功能,如在各实例的根桥设备的指定端口配置根保护功能

# 在SwitchA端口GE1/0/1上启动根保护。

[SwitchA] interface gigabitethernet 1/0/1

[SwitchA-GigabitEthernet1/0/1] stp root-protection

[SwitchA-GigabitEthernet1/0/1] quit

# 在SwitchB端口GE1/0/1上启动根保护。

[SwitchB] interface gigabitethernet 1/0/1

[SwitchB-GigabitEthernet1/0/1] stp root-protection

[SwitchB-GigabitEthernet1/0/1] quit步骤3 配置处于环网中的设备的二层转发功能

l 在交换设备SwitchA、SwitchB、SwitchC上创建VLAN2~3

# 在SwitchA上创建VLAN2~3。

[SwitchA] vlan batch 2 to 3

# 在SwitchB上创建VLAN2~3。

[SwitchB] vlan batch 2 to 3

# 在SwitchC上创建VLAN2~3。

[SwitchC] vlan batch 2 to 3l 将交换设备上接入环路中的端口加入VLAN

# 将SwitchA端口GE1/0/1加入VLAN。

[SwitchA] interface gigabitethernet 1/0/1

[SwitchA-GigabitEthernet1/0/1] port link-type trunk

[SwitchA-GigabitEthernet1/0/1] port trunk allow-pass vlan 2 to 3

[SwitchA-GigabitEthernet1/0/1] quit

# 将SwitchA端口GE1/0/2加入VLAN。

[SwitchA] interface gigabitethernet 1/0/2

[SwitchA-GigabitEthernet1/0/2] port link-type trunk

[SwitchA-GigabitEthernet1/0/2] port trunk allow-pass vlan 2 to 3

[SwitchA-GigabitEthernet1/0/2] quit

# 将SwitchB端口GE1/0/1加入VLAN。

[SwitchB] interface gigabitethernet 1/0/1

[SwitchB-GigabitEthernet1/0/1] port link-type trunk

[SwitchB-GigabitEthernet1/0/1] port trunk allow-pass vlan 2 to 3

[SwitchB-GigabitEthernet1/0/1] quit

# 将SwitchB端口GE1/0/2加入VLAN。

[SwitchB] interface gigabitethernet 1/0/2

[SwitchB-GigabitEthernet1/0/2] port link-type trunk

[SwitchB-GigabitEthernet1/0/2] port trunk allow-pass vlan 2 to 3

[SwitchB-GigabitEthernet1/0/2] quit

# 将SwitchC端口GE1/0/1加入VLAN。

[SwitchC] interface gigabitethernet 1/0/1

[SwitchC-GigabitEthernet1/0/1] port link-type trunk

[SwitchC-GigabitEthernet1/0/1] port trunk allow-pass vlan 2 to 3

[SwitchC-GigabitEthernet1/0/1] quit

# 将SwitchC端口GE1/0/2加入VLAN。

[SwitchC] interface gigabitethernet 1/0/2

[SwitchC-GigabitEthernet1/0/2] port link-type access

[SwitchC-GigabitEthernet1/0/2] port default vlan 2

[SwitchC-GigabitEthernet1/0/2] quit

# 将SwitchC端口GE1/0/3加入VLAN。

[SwitchC] interface gigabitethernet 1/0/3

[SwitchC-GigabitEthernet1/0/3] port link-type access

[SwitchC-GigabitEthernet1/0/3] port default vlan 3

[SwitchC-GigabitEthernet1/0/3] quit

# 将SwitchC端口GE1/0/4加入VLAN。

[SwitchC] interface gigabitethernet 1/0/4

[SwitchC-GigabitEthernet1/0/4] port link-type trunk

[SwitchC-GigabitEthernet1/0/4] port trunk allow-pass vlan 2 to 3

[SwitchC-GigabitEthernet1/0/4] quit步骤4 验证配置结果

经过以上配置,在网络计算稳定后,执行以下操作,验证配置结果。

说明

本配置举例以实例1和实例2为例,因此不用关注实例0中端口的状态。

在SwitchA上执行display stp brief命令,查看端口状态和端口的保护类型,结果如

下:

[SwitchA] display stp brief

MSTID Port Role STP State Protection

0 GigabitEthernet1/0/1 DESI FORWARDING ROOT

0 GigabitEthernet1/0/2 DESI FORWARDING NONE

1 GigabitEthernet1/0/1 DESI FORWARDING ROOT

1 GigabitEthernet1/0/2 DESI FORWARDING NONE

2 GigabitEthernet1/0/1 DESI FORWARDING ROOT

2 GigabitEthernet1/0/2 ROOT FORWARDING NONE在MSTI1中,由于SwitchA是根桥,SwitchA的端口GE1/0/2和GE1/0/1成为指定端口。在

MSTI2中,SwitchA的端口GE1/0/1成为指定端口,端口GE1/0/2成为根端口。

在SwitchB上执行display stp brief命令,结果如下:

[SwitchB] display stp brief

MSTID Port Role STP State Protection

0 GigabitEthernet1/0/1 DESI FORWARDING ROOT

0 GigabitEthernet1/0/2 ROOT FORWARDING NONE

1 GigabitEthernet1/0/1 DESI FORWARDING ROOT

1 GigabitEthernet1/0/2 ROOT FORWARDING NONE

2 GigabitEthernet1/0/1 DESI FORWARDING ROOT

2 GigabitEthernet1/0/2 DESI FORWARDING NONE在MSTI2中,由于SwitchB是根桥,端口GE1/0/1和GE1/0/2在MSTI2中成为指定端口。

在MSTI1中,SwitchB的端口GE1/0/1成为指定端口,端口GE1/0/2成为根端口。

在SwitchC上执行display stp interface brief命令,结果如下:

[SwitchC] display stp interface gigabitethernet 1/0/1 brief

MSTID Port Role STP State Protection

0 GigabitEthernet1/0/1 ROOT FORWARDING NONE

1 GigabitEthernet1/0/1 ROOT FORWARDING NONE

2 GigabitEthernet1/0/1 ALTE DISCARDING NONE

[SwitchC] display stp interface gigabitethernet 1/0/4 brief

MSTID Port Role STP State Protection

0 GigabitEthernet1/0/4 ALTE DISCARDING NONE

1 GigabitEthernet1/0/4 ALTE DISCARDING NONE

2 GigabitEthernet1/0/4 ROOT FORWARDING NONESwitchC的端口GE1/0/1在MSTI1中为根端口,在MSTI2中被阻塞。SwitchC的另一个端

口GE1/0/4,在MSTI1中被阻塞,在MSTI2中为根端口。

步骤5 配置设备间的网络互连

配置设备各端口的IP地址,以SwitchA为例。SwitchB的配置与SwitchA类似,详见配

置文件。

[SwitchA] vlan batch 4

[SwitchA] interface gigabitethernet 1/0/3

[SwitchA-GigabitEthernet1/0/3] port link-type trunk

[SwitchA-GigabitEthernet1/0/3] port trunk allow-pass vlan 4

[SwitchA-GigabitEthernet1/0/3] quit

[SwitchA] interface vlanif 2

[SwitchA-Vlanif2] ip address 10.1.2.102 24

[SwitchA-Vlanif2] quit

[SwitchA] interface vlanif 3

[SwitchA-Vlanif3] ip address 10.1.3.102 24

[SwitchA-Vlanif3] quit

[SwitchA] interface vlanif 4

[SwitchA-Vlanif4] ip address 10.1.4.102 24

[SwitchA-Vlanif4] quit配置SwitchA、SwitchB和路由器间采用OSPF协议进行互连。以SwitchA为例,

SwitchB的配置与SwitchA类似,详见配置文件。

[SwitchA] ospf 1

[SwitchA-ospf-1] area 0

[SwitchA-ospf-1-area-0.0.0.0] network 10.1.2.0 0.0.0.255

[SwitchA-ospf-1-area-0.0.0.0] network 10.1.3.0 0.0.0.255

[SwitchA-ospf-1-area-0.0.0.0] network 10.1.4.0 0.0.0.255

[SwitchA-ospf-1-area-0.0.0.0] quit

[SwitchA-ospf-1] quit步骤6 配置VRRP备份组

在SwitchA和SwitchB上创建VRRP备份组1,配置SwitchA的优先级为120,抢占延时

为20秒,作为Master设备;SwitchB的优先级为缺省值,作为Backup设备。

[SwitchA] interface vlanif 2

[SwitchA-Vlanif2] vrrp vrid 1 virtual-ip 10.1.2.100 //创建组号为1的VRRP备份组并为备份组指定虚拟IP地址10.1.2.100。

[SwitchA-Vlanif2] vrrp vrid 1 priority 120 //配置VRRP备份组1的优先级为120。

[SwitchA-Vlanif2] vrrp vrid 1 preempt-mode timer delay 20 //配置VRRP备份组1抢占延时为20秒。

[SwitchA-Vlanif2] quit

[SwitchB] interface vlanif 2

[SwitchB-Vlanif2] vrrp vrid 1 virtual-ip 10.1.2.100 //创建组号为1的VRRP备份组并为备份组指定虚拟IP地址10.1.2.100。

[SwitchB-Vlanif2] quit在SwitchA和SwitchB上创建VRRP备份组2,配置SwitchB的优先级为120,抢占延时为

20秒,作为Master设备;SwitchA的优先级为缺省值,作为Backup设备。

[SwitchB] interface vlanif 3

[SwitchB-Vlanif3] vrrp vrid 2 virtual-ip 10.1.3.100 //创建组号为2的VRRP备份组并为备份组指定虚拟IP地址10.1.3.100。

[SwitchB-Vlanif3] vrrp vrid 2 priority 120 //配置VRRP备份组1的优先级为120。

[SwitchB-Vlanif3] vrrp vrid 2 preempt-mode timer delay 20 //配置VRRP备份组2抢占延时为20秒。

[SwitchB-Vlanif3] quit

[SwitchA] interface vlanif 3

[SwitchA-Vlanif3] vrrp vrid 2 virtual-ip 10.1.3.100 //创建组号为2的VRRP备份组并为备份组指定虚拟IP地址10.1.3.100。

[SwitchA-Vlanif3] quit配置主机HostA的缺省网关为备份组1的虚拟IP地址10.1.2.100,配置主机HostB的缺省

网关为备份组2的虚拟IP地址10.1.3.100。

步骤7 验证配置结果

完成上述配置后,在SwitchA上执行display vrrp命令,可以看到SwitchA在备份组1中

作为Master设备,在备份组2中作为Backup设备。

[SwitchA] display vrrp

Vlanif2 | Virtual Router 1

State : Master

Virtual IP : 10.1.2.100

Master IP : 10.1.2.102

PriorityRun : 120

PriorityConfig : 120

MasterPriority : 120

Preempt : YES Delay Time : 20 s

TimerRun : 1 s

TimerConfig : 1 s

Auth type : NONE

Virtual MAC : 0000-5e00-0101

Check TTL : YES

Config type : normal-vrrp

Backup-forward : disabled

Create time : 2012-05-11 11:39:18

Last change time : 2012-05-26 11:38:58

Vlanif3 | Virtual Router 2

State : Backup

Virtual IP : 10.1.3.100

Master IP : 10.1.3.103

PriorityRun : 100

PriorityConfig : 100

MasterPriority : 120

Preempt : YES Delay Time : 0 s

TimerRun : 1 s

TimerConfig : 1 s

Auth type : NONE

Virtual MAC : 0000-5e00-0102

Check TTL : YES

Config type : normal-vrrp

Backup-forward : disabled

Create time : 2012-05-11 11:40:18

Last change time : 2012-05-26 11:48:58在SwitchB上执行display vrrp命令,可以看到SwitchB在备份组1中作为Backup设备,

在备份组2中作为Master设备。

[SwitchB] display vrrp

Vlanif2 | Virtual Router 1

State : Backup

Virtual IP : 10.1.2.100

Master IP : 10.1.2.102

PriorityRun : 100

PriorityConfig : 100

MasterPriority : 120

Preempt : YES Delay Time : 0 s

TimerRun : 1 s

TimerConfig : 1 s

Auth type : NONE

Virtual MAC : 0000-5e00-0101

Check TTL : YES

Config type : normal-vrrp

Backup-forward : disabled

Create time : 2012-05-11 11:39:18

Last change time : 2012-05-26 11:38:58

Vlanif3 | Virtual Router 2

State : Master

Virtual IP : 10.1.3.100

Master IP : 10.1.3.103

PriorityRun : 120

PriorityConfig : 120

MasterPriority : 120

Preempt : YES Delay Time : 20 s

TimerRun : 1 s

TimerConfig : 1 s

Auth type : NONE

Virtual MAC : 0000-5e00-0102

Check TTL : YES

Config type : normal-vrrp

Backup-forward : disabled

Create time : 2012-05-11 11:40:18

Last change time : 2012-05-26 11:48:58 ----结束

配置文件

SwitchA的配置文件

#

sysname SwitchA

#

vlan batch 2 to 4

#

stp instance 1 root primary

stp instance 2 root secondary

stp bpdu-protection

stp pathcost-standard legacy

#

stp region-configuration

region-name RG1

instance 1 vlan 2

instance 2 vlan 3

active region-configuration

#

interface Vlanif2

ip address 10.1.2.102 255.255.255.0

vrrp vrid 1 virtual-ip 10.1.2.100

vrrp vrid 1 priority 120

vrrp vrid 1 preempt-mode timer delay 20

#

interface Vlanif3

ip address 10.1.3.102 255.255.255.0

vrrp vrid 2 virtual-ip 10.1.3.100

#

interface Vlanif4

ip address 10.1.4.102 255.255.255.0

#

interface GigabitEthernet1/0/1

port link-type trunk

port trunk allow-pass vlan 2 to 3

stp root-protection

#

interface GigabitEthernet1/0/2

port link-type trunk

port trunk allow-pass vlan 2 to 3

#

interface GigabitEthernet1/0/3

port link-type trunk

port trunk allow-pass vlan 4

stp edged-port enable

#

ospf 1

area 0.0.0.0

network 10.1.2.0 0.0.0.255

network 10.1.3.0 0.0.0.255

network 10.1.4.0 0.0.0.255

#

returnSwitchB的配置文件

#

sysname SwitchB

#

vlan batch 2 to 3 5

#

stp instance 1 root secondary

stp instance 2 root primary

stp bpdu-protection

stp pathcost-standard legacy

#

stp region-configuration

region-name RG1

instance 1 vlan 2

instance 2 vlan 3

active region-configuration

#

interface Vlanif2

ip address 10.1.2.103 255.255.255.0

vrrp vrid 1 virtual-ip 10.1.2.100

#

interface Vlanif3

ip address 10.1.3.103 255.255.255.0

vrrp vrid 2 virtual-ip 10.1.3.100

vrrp vrid 2 priority 120

vrrp vrid 2 preempt-mode timer delay 20

#

interface Vlanif5

ip address 10.1.5.103 255.255.255.0

#

interface GigabitEthernet1/0/1

port link-type trunk

port trunk allow-pass vlan 2 to 3

stp root-protection

#

interface GigabitEthernet1/0/2

port link-type trunk

port trunk allow-pass vlan 2 to 3

#

interface GigabitEthernet1/0/3

port link-type trunk

port trunk allow-pass vlan 5

stp edged-port enable

#

ospf 1

area 0.0.0.0

network 10.1.2.0 0.0.0.255

network 10.1.3.0 0.0.0.255

network 10.1.5.0 0.0.0.255

#

returnSwitchC的配置文件

#

sysname SwitchC

#

vlan batch 2 to 3

#

stp bpdu-protection

stp pathcost-standard legacy

#

stp region-configuration

region-name RG1

instance 1 vlan 2

instance 2 vlan 3

active region-configuration

#

interface GigabitEthernet1/0/1

port link-type trunk

port trunk allow-pass vlan 2 to 3

stp instance 2 cost 20000

#

interface GigabitEthernet1/0/2

port link-type access

port default vlan 2

stp edged-port enable

#

interface GigabitEthernet1/0/3

port link-type access

port default vlan 3

stp edged-port enable

#

interface GigabitEthernet1/0/4

port link-type trunk

port trunk allow-pass vlan 2 to 3

stp instance 1 cost 20000

#

return